1. Spring Batch 介绍

企业域内的许多应用程序都需要批量处理才能在关键任务环境中执行业务操作。这些业务操作包括自动化,复杂的海量信息处理,无需用户交互即可最有效地进行处理。这些操作通常包括基于时间的事件(例如,月末计算,通知或通信),周期性应用非常大的数据集重复处理的复杂业务规则(例如,保险利益确定或费率调整)或所接收信息的集成从通常需要以事务处理方式进行格式化,验证和处理的内部和外部系统进入记录系统。批处理每天用于为企业处理数十亿笔事务。

Spring Batch 是一个轻量级的,全面的批处理框架,旨在支持开发对企业系统的日常运行至关重要的强大的批处理应用程序。 Spring Batch 构建在生产力,基于 POJO 的开发方法以及人们从 Spring 框架中了解到的通用易用性的基础之上,同时使开发人员在必要时可以轻松访问和利用更高级的企业服务。 Spring Batch 不是一个调度框架。商业和开放源代码空间(例如 Quartz,Tivoli,Control-M 等)中都有许多好的企业调度程序。它旨在与调度程序结合使用,而不是替换调度程序。

Spring Batch 提供了可重用的功能,这些功能对于处理大量记录至关重要,包括日志记录/跟踪,事务 Management,作业处理统计信息,作业重启,跳过和资源 Management。它还提供了更高级的技术服务和功能,这些功能和功能将通过优化和分区技术来实现极高容量和高性能的批处理作业。简单以及复杂的大批量批处理作业都可以以高度可扩展的方式利用框架来处理大量信息。

1.1 Background

尽管开源软件 Item 和相关社区将更多的注意力放在基于 Web 的和基于 SOA 消息传递的架构框架上,但是尽管满足了持续的处理需求,但是对于可重用的架构框架却缺乏足够的关注以适应基于 Java 的批处理需求。企业 IT 环境中的此类处理。缺乏标准的,可重复使用的批处理体系结构,导致在 Client 端企业 IT 功能内开发的许多一次性内部解决方案激增。

SpringSource 和埃森哲合作进行了更改。埃森哲(Accenture)在实现批处理体系结构方面的动手行业和技术经验,SpringSource 的深厚技术经验以及 Spring 久经验证的编程模型共同标志着自然而强大的合作伙伴关系,以创建旨在填补企业 Java 重要缺口的高质量,与市场相关的软件。两家公司目前还与许多 Client 合作,共同开发基于 Spring 的批处理体系结构解决方案,以解决类似的问题。这提供了一些有用的附加细节和现实生活中的约束条件,有助于确保解决方案可以应用于 Client 提出的现实问题。由于这些原因,SpringSource 和埃森哲(Accenture)携手合作,共同开发 Spring Batch。

埃森哲基于数十年在使用最后几代平台(例如,COBOL/Mainframe,C/Unix,现在是 Java /任何地方)构建批处理架构方面的经验,为 Spring BatchItem 贡献了以前专有的批处理架构框架。以及提交者资源,以推动支持,增强功能和 FutureRoute 图。

埃森哲与 SpringSource 的合作旨在促进软件处理方法,框架和工具的标准化,企业用户在创建批处理应用程序时可以一致地利用它们。希望为企业 IT 环境提供标准的,经过验证的解决方案的公司和政府机构将从 Spring Batch 中受益。

1.2 使用场景

典型的批处理程序通常从数据库,文件或队列中读取大量记录,以某种方式处理数据,然后以修改后的形式写回数据。 Spring Batch 自动执行此基本批处理迭代,从而提供了将一组类似的事务作为一组处理的功能,通常在脱机环境中无需任何用户交互。批处理作业是大多数 ITItem 的一部分,Spring Batch 是唯一提供可靠的企业级解决方案的开源框架。

Business Scenarios

- 定期提交批处理

- 并行批处理:作业的并行处理

- 分阶段的企业消息驱动的处理

- 大规模并行批处理

- 失败后手动或计划重启

- Sequences 处理相关步骤(扩展了工作流程驱动的批次)

- 部分处理:跳过记录(例如回滚)

- 整批事务:适用于小批量或现有存储过程/脚本的情况

Technical Objectives

- 批处理开发人员使用 Spring 编程模型:专注于业务逻辑;让框架照顾基础架构。

- 在基础结构,批处理执行环境和批处理应用程序之间明确分离关注点。

- 提供通用的核心执行服务作为所有 Item 都可以实现的接口。

- 提供可以直接使用的核心执行接口的简单和默认实现。

- 通过在所有层中利用 spring 框架,轻松配置,定制和扩展服务。

- 所有现有的核心服务应易于替换或扩展,而不会影响基础架构层。

- 提供一个简单的部署模型,其架构 JAR 与使用 Maven 构建的应用程序完全分开。

1.3 Spring Batch 体系结构

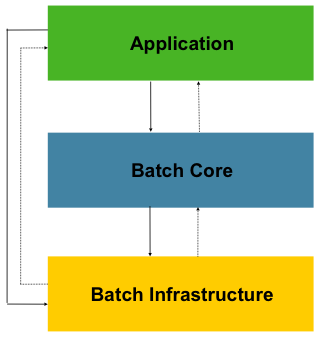

Spring Batch 设计时考虑了可扩展性,并考虑了不同的最终用户群体。下图显示了分层体系结构的草图,该结构支持最终用户开发人员的可扩展性和易用性。

图 1.1:Spring Batch 分层架构

这种分层的体系结构突出了三个主要的高级组件:应用程序,核心和基础结构。该应用程序包含所有批处理作业和开发人员使用 Spring Batch 编写的自定义代码。批处理核心包含启动和控制批处理作业所需的核心运行时类。它包括诸如JobLauncher,Job和Step的实现。 Application 和 Core 都构建在通用基础架构之上。此基础结构包含通用的读取器和写入器,以及RetryTemplate之类的服务,应用程序开发人员(ItemReader和ItemWriter)以及核心框架本身都使用它们。 (重试)

1.4 一般批处理原则和准则

以下是构建批处理解决方案时要考虑的一些关键原则,准则和一般注意事项。

- 批处理体系结构通常会影响在线体系结构,反之亦然。在可能的情况下,请使用通用的构建块同时考虑架构和环境进行设计。

- 尽可能简化并避免在单个批处理应用程序中构建复杂的逻辑结构。

- 处理数据时应尽可能靠近其物理位置(反之亦然)(即,将数据保留在进行处理的位置)。

- 最小化系统资源的使用,尤其是 I/O。在内存中执行尽可能多的操作。

- 查 Watch 应用程序 I/O(分析 SQL 语句)以确保避免不必要的物理 I/O。特别是,需要寻找以下四个常见缺陷:

- 当可以一次读取数据并将其缓存或保存在工作存储器中时,为每个事务读取数据;

- 重新读取事务的数据,其中在同一事务中较早读取了该数据;

- 导致不必要的表或索引扫描;

- 没有在 SQL 语句的 WHERE 子句中指定键值。

- 请勿在批处理中两次执行操作。例如,如果出于报告目的需要数据汇总,则在初始处理数据时,如果可能,请增加存储的总数,因此报告应用程序不必重新处理相同的数据。

- 在批处理应用程序开始时分配足够的内存,以避免在此过程中耗时的重新分配。

- 关于数据完整性,请始终假设最坏的情况。插入足够的检查并记录验证以维护数据完整性。

- 实施校验和以进行内部验证。例如,平面文件应具有预告片记录,以告知文件中的记录总数以及关键字段的集合。

- 在具有实际数据量的类似生产的环境中,尽早计划和执行压力测试。

- 在大型批处理系统中,备份可能具有挑战性,尤其是当系统以 24-7 联机联机运行时。在线设计中通常会妥善处理数据库备份,但是文件备份也应同样重要。如果系统依赖平面文件,则不仅应构建文件备份程序并形成文件,还应进行定期测试。

1.5 批处理策略

为了帮助设计和实现批处理系统,应以示例结构图和代码 Shell 的形式向设计人员和程序员提供基本的批处理应用程序构建模块和模式。在开始设计批处理作业时,应将业务逻辑分解为一系列步骤,可以使用以下标准构件来实现:

- *转换应用程序:*对于由外部系统提供或生成的每种文件类型,都需要创建一个转换应用程序,以将提供的事务记录转换为处理所需的标准格式。这种批处理应用程序可以部分或全部由翻译 Util 模块组成(请参阅基本批处理服务)。

- *验证应用程序:*验证应用程序可确保所有 Importing/输出记录正确且一致。验证通常基于文件头和尾标,校验和和验证算法以及记录级别的交叉检查。

- *提取应用程序:*一个应用程序,它从数据库或 Importing 文件中读取一组记录,根据 sched 义的规则选择记录,然后将记录写入输出文件。

- *提取/更新应用程序:*一个应用程序,它从数据库或 Importing 文件中读取记录,并根据每个 ImportingLogging 找到的数据来驱动对数据库或输出文件的更改。

- *处理和更新应用程序:*一个应用程序,用于对来自摘录或验证应用程序的 Importing 事务进行处理。处理通常将涉及读取数据库以获得处理所需的数据,可能会更新数据库并创建记录以进行输出处理。

- *输出/格式应用程序:*应用程序读取 Importing 文件,根据标准格式从该 Logging 重组数据,并生成输出文件以供打印或传输到另一个程序或系统。

此外,应为无法使用前面提到的构建块构建的业务逻辑提供基本的应用程序 Shell。

除主要构建块外,每个应用程序都可以使用一个或多个标准 Util 步骤,例如:

- 排序-一种程序,该程序读取 Importing 文件并生成输出文件,其中已根据 Logging 的排序键字段对记录进行了重新排序。排序通常由标准系统 Util 执行。

- 拆分-一种程序,它读取一个 Importing 文件,并根据字段值将每个记录写入几个输出文件之一。拆分可以由参数驱动的标准系统 Util 定制或执行。

- 合并-一种程序,可从多个 Importing 文件中读取记录,并使用 Importing 文件中的合并数据生成一个输出文件。合并可以通过参数驱动的标准系统 Util 来定制或执行。

批处理应用程序还可以按其 Importing 源进行分类:

- 数据库驱动的应用程序由从数据库检索的行或值驱动。

- 文件驱动的应用程序由从文件中检索的记录或值驱动。

- 消息驱动的应用程序由从消息队列检索的消息驱动。

任何批处理系统的基础都是处理策略。影响策略选择的因素包括:估计的批处理系统数量,与联机或其他批处理系统的并发性,可用的批处理窗口(以及更多希望以 24x7 全天候运行的企业,因此没有明显的批处理窗口)。

批处理的典型处理选项是:

- 脱机期间在批处理窗口中进行正常处理

- 并行批处理/在线处理

- 同时并行处理许多不同的批生产或作业

- 分区(即同时处理同一作业的许多实例)

- 这些的结合

上面列表中的 Sequences 反映了实现的复杂性,在批处理窗口中的处理最容易实现,而对分区的实现最复杂。

商业调度程序可能会支持其中一些或全部选项。

在以下部分中,将详细讨论这些处理选项。重要的是要注意,批处理过程采用的提交和锁定策略将取决于执行的处理类型,并且根据经验,在线锁定策略也应使用相同的原理。因此,在设计整体体系结构时,批处理体系结构不能仅是事后的想法。

锁定策略只能使用普通数据库锁定,或者可以在体系结构中实现其他自定义锁定服务。锁定服务将跟踪数据库锁定(例如,通过将必要的信息存储在专用的 db 表中),并为请求 db 操作的应用程序提供或拒绝权限。此体系结构也可以实现重试逻辑,以避免在锁定情况下中止批处理作业。

1.批处理窗口中的正常处理 对于在单独的批处理窗口中运行的简单批处理过程,在线用户或其他批处理过程不需要更新数据,并发不是问题,可以在以下位置进行一次提交批处理运行结束。

在大多数情况下,更健壮的方法更为合适。要记住的是,批处理系统会随着时间的流逝而增长,无论是从复杂性还是要处理的数据量来 Watch。如果没有锁定策略,并且系统仍依赖单个提交点,则修改批处理程序可能会很麻烦。因此,即使使用最简单的批处理系统,也要考虑需要重新启动-恢复选项的提交逻辑以及有关以下更复杂情况的信息。

2.并行批处理/在线处理 处理在线用户可以同时更新的数据的批处理应用程序,不应锁定在线用户可能需要的任何数据(数据库或文件中的数据)几秒钟。同样,在每笔事务结束时,更新也应提交给数据库。这样可以将其他进程不可用的数据部分和数据不可用的经过时间最小化。

最小化物理锁定的另一种方法是使用乐观锁定模式或悲观锁定模式来实现逻辑行级锁定。

- 乐观锁定假定记录争用的可能性很小。通常,这意味着在批处理和联机处理同时使用的每个数据库表中插入一个时间戳列。当应用程序获取一行进行处理时,它还将获取时间戳。然后,当应用程序尝试更新已处理的行时,更新将使用 WHERE 子句中的原始时间戳。如果时间戳匹配,则数据和时间戳将成功更新。如果时间戳不匹配,则表明另一个应用程序已经更新了获取和更新尝试之间的同一行,因此无法执行更新。

- 悲观锁定是任何假定记录争用可能性很高的锁定策略,因此需要在检索时获得物理或逻辑锁定。一种悲观逻辑锁定使用数据库表中的专用锁定列。当应用程序检索要更新的行时,它将在锁列中设置一个标志。有了该标志,其他尝试检索同一行的应用程序在逻辑上将失败。当设置标志的应用程序更新该行时,它还会清除该标志,从而使该行可以被其他应用程序检索。请注意,在初始获取和设置标志之间还必须保持数据的完整性,例如通过使用 db 锁(例如 SELECT FOR UPDATE)。还要注意,该方法与物理锁定有相同的缺点,除了 Management 超时机制要容易一些,该机制可以在锁定记录的情况下在用户午餐时释放锁定。

这些模式不一定适用于批处理,但可以用于并发批处理和联机处理(例如,在数据库不支持行级锁定的情况下)。通常,乐观锁定更适合于在线应用程序,而悲观锁定更适合于批处理应用程序。每当使用逻辑锁定时,必须对访问逻辑锁定保护的数据实体的所有应用程序使用相同的方案。

请注意,这两种解决方案都只解决锁定单个记录的问题。通常,我们可能需要锁定逻辑上相关的记录组。使用物理锁,您必须非常仔细地 Management 这些锁,以避免潜在的死锁。使用逻辑锁,通常最好构建一个逻辑锁 Management 器,该 Management 器了解要保护的逻辑记录组,并可以确保锁是连贯的和非死锁的。此逻辑锁 Management 器通常使用自己的表进行锁 Management,争用报告,超时机制等。

3.并行处理 并行处理允许多个批处理运行/作业并行运行,以最大程度地减少总的批处理处理时间。只要作业不共享相同的文件,数据库表或索引空间,就没有问题。如果这样做,则应使用分区数据来实现此服务。另一种选择是构建一个架构模块,以使用控制表来维护相互依赖性。控制表应为每个共享资源及其是否由应用程序使用而包含一行。然后,批处理体系结构或并行作业中的应用程序将从该表中检索信息,以确定它是否可以访问所需的资源。

如果数据访问没有问题,则可以通过使用其他线程进行并行处理来实现并行处理。在大型机环境中,传统上使用并行作业类,以确保所有进程有足够的 CPU 时间。无论如何,该解决方案必须足够强大以确保所有正在运行的进程的时间片。

并行处理中的其他关键问题包括负载平衡和常规系统资源(例如文件,数据库缓冲池等)的可用性。还请注意,控制表本身很容易成为关键资源。

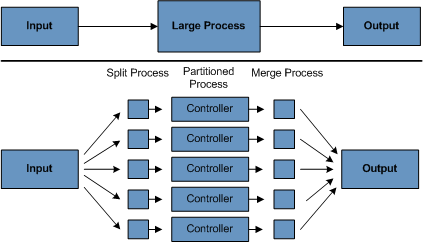

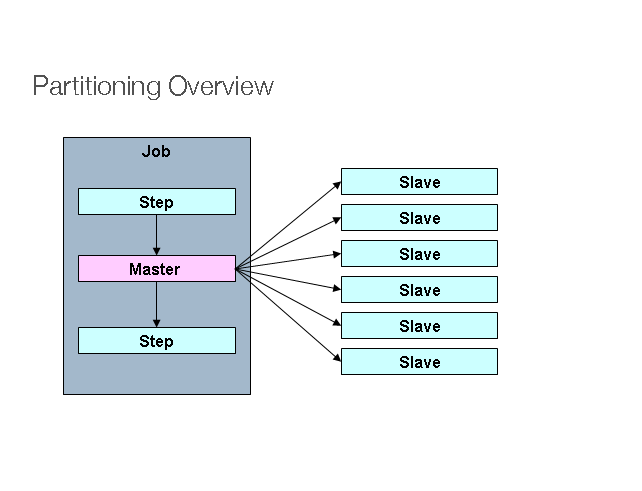

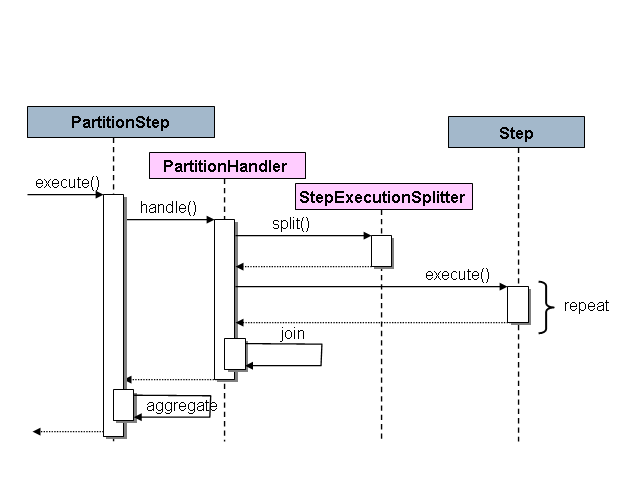

4.分区 使用分区允许大型批处理应用程序的多个版本同时运行。这样做的目的是减少处理长批处理作业所需的时间。可以成功分区的进程是可以拆分 Importing 文件和/或对主数据库表进行分区以允许应用程序针对不同的数据集运行的进程。

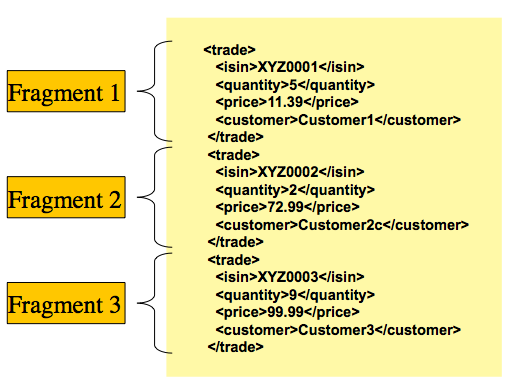

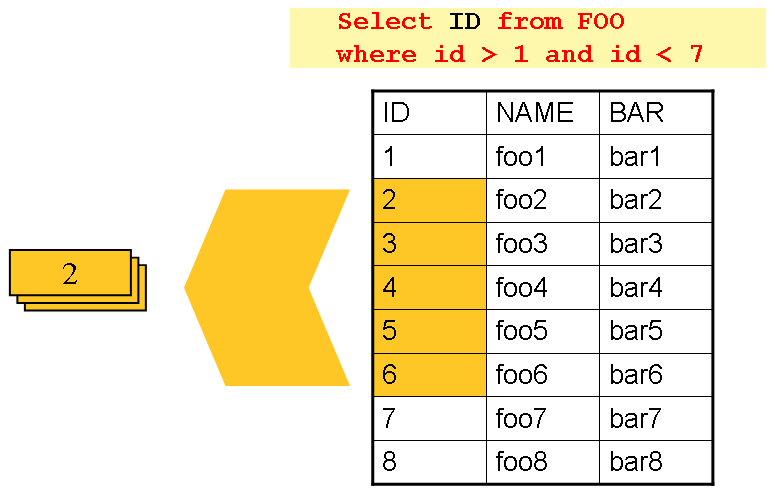

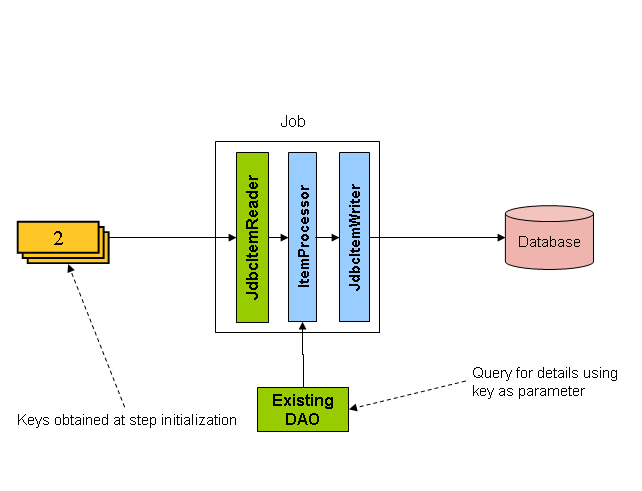

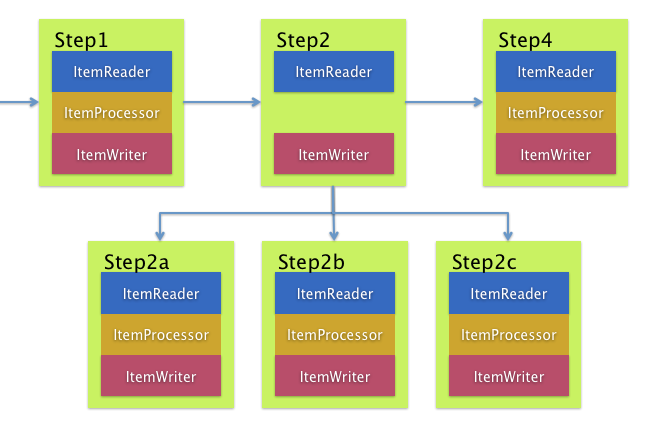

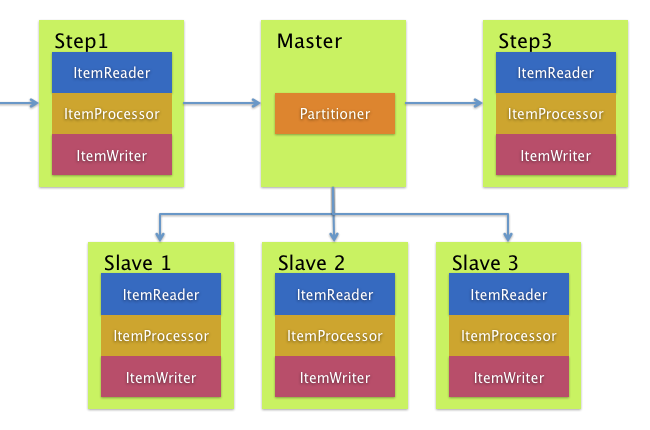

此外,已分区的进程必须设计为仅处理其分配的数据集。分区体系结构必须与数据库设计和数据库分区策略紧密联系在一起。请注意,数据库分区不一定意味着数据库的物理分区,尽管在大多数情况下这是可取的。下图说明了分区方法:

图 1.2:分区过程

该架构应足够灵活,以允许动态配置分区数量。自动配置和用户控制配置均应考虑。自动配置可以基于诸如 Importing 文件大小和/或 Importing 记录数之类的参数。

4.1 分区方法 以下列出了一些可能的分区方法。选择分区方法必须根据具体情况进行。

- 1.记录集的固定和均匀分解*

这涉及将 Importing 记录集分成偶数个部分(例如 10 个,其中每个部分恰好占整个记录集的 1⁄10)。然后由批处理/提取应用程序的一个实例处理每个部分。

为了使用此方法,将需要进行预处理以拆分记录集。拆分的结果将是一个上下限放置数,可以将其用作批处理/提取应用程序的 Importing,以便将其处理仅限于其部分。

预处理可能会产生很大的开销,因为它必须计算并确定记录集每个部分的界限。

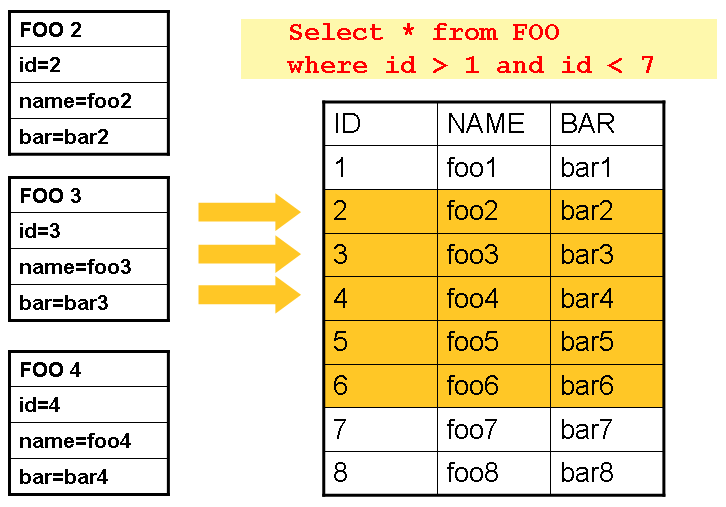

- 2.按关键列细分*

这涉及通过键列(例如位置代码)分解 Importing 记录集,并将每个键的数据分配给批处理实例。为了实现这一点,列值可以是

- 3.通过分区表分配给批处理实例(有关详细信息,请参见下文).*

- 4.通过部分值(例如值 0000-0999、1000-1999 等)分配给批处理实例*

在选项 1 下,添加新值将意味着手动重新配置批次/提取,以确保将新值添加到特定实例。

在选项 2 下,这将确保通过批处理作业实例覆盖所有值。但是,由一个实例处理的值的数量取决于列值的分布(即,在 0000-0999 范围内可能有大量位置,而在 1000-1999 范围内可能很少)。在此选项下,数据范围的设计应考虑分区。

在这两种选择下,都无法实现记录到批处理实例的最佳均匀分配。没有动态配置所使用的批处理实例的数量。

- 5.按观 Watch 次数细分*

这种方法基本上是按键列拆分的,但是在数据库级别。它涉及将记录集分解为视图。批处理应用程序的每个实例在处理过程中将使用这些视图。分解将通过对数据进行分组来完成。

使用此选项,必须将批处理应用程序的每个实例配置为命中特定视图(而不是主表)。同样,随着新数据值的添加,该新数据组将必须包含在视图中。没有动态配置功能,因为实例数量的更改将导致视图的更改。

- 6.添加加工 Metrics*

这涉及在 Importing 表中添加一个新列,该列用作指示符。作为预处理步骤,所有 Metrics 都将标记为未处理。在批处理应用程序的记录获取阶段,将以该记录被标记为未处理的条件来读取记录,并且一旦读取(带锁)它们便被标记为正在处理。该记录完成后,指示符将更新为完成或错误。批处理应用程序的许多实例无需更改即可启动,因为附加列可确保记录仅处理一次。

使用此选项,表上的 I/O 会动态增加。在更新批处理应用程序的情况下,这种影响会减小,因为无论如何都要进行写操作。

- 7.将表提取到平面文件*

这涉及将表提取到文件中。然后可以将此文件拆分为多个段,并用作批处理实例的 Importing。

使用此选项,将表提取到文件中并进行拆分的额外开销可能会抵消多分区的影响。通过更改文件分割脚本可以实现动态配置。

- 8.哈希列的使用*

此方案涉及在用于检索驱动程序记录的数据库表中添加哈希列(键/索引)。该哈希列将具有指示符,用于确定批处理应用程序的哪个实例将处理此特定行。例如,如果有三个批处理实例要启动,则指示符“ A”将标记该行以供实例 1 处理,指示符“ B”将标记该行以供实例 2 处理,以此类推。

然后,用于检索记录的过程将具有一个附加的 WHERE 子句,以选择由特定指示符标记的所有行。此表中的插入内容将涉及添加标记字段,该字段默认为实例之一(例如’A’)。

一个简单的批处理应用程序将用于更新 Metrics,例如在不同实例之间重新分配负载。添加足够多的新行后,可以运行该批处理(除批处理窗口外,任何时候均可)将新行重新分配给其他实例。

批处理应用程序的其他实例仅需要运行上述批处理应用程序即可重新分配指示符,以适应新的实例数量。

4.2 数据库和应用程序设计原则

支持使用键列方法针对分区数据库表运行的多分区应用程序的体系结构应包括用于存储分区参数的中央分区存储库。这提供了灵 Active 并确保了可维护性。该存储库通常由一个称为分区表的表组成。

存储在分区表中的信息将是静态的,并且通常应由 DBA 维护。该表应包含一个信息行,用于多分区应用程序的每个分区。该表应包含以下列:程序 ID 代码,分区号(分区的逻辑 ID),该分区的 db 键列的低值,此分区的 db 键列的高值。

在程序启动时,应将程序 ID 和分区号从体系结构传递到应用程序(控制处理任务集)。这些变量用于读取分区表,以确定应用程序要处理的数据范围(如果使用键列方法)。此外,在整个处理过程中必须使用分区号以:

- 添加到输出文件/数据库更新中以使合并过程正常运行

- 将正常处理报告给批处理日志,并将在执行过程中发生的任何错误报告给体系结构错误处理程序

4.3 最小化死锁

当应用程序并行或分区运行时,数据库资源争用和死锁可能发生。至关重要的是,数据库设计团队应尽可能消除潜在的争用情况,这是数据库设计的一部分。

还要确保数据库索引表在设计时考虑了防止死锁和性能。

死锁或热点通常发生在 Management 或体系结构表中,例如日志表,控制表和锁定表。还应考虑这些含义。实际的压力测试对于确定体系结构中的可能瓶颈至关重要。

为了最大程度地减少冲突对数据的影响,体系结构应在连接到数据库或遇到死锁时提供诸如 await 和重试间隔之类的服务。这意味着内置机制可以对某些数据库返回码作出反应,而不是立即发出错误处理,而是 awaitsched 时间并重试数据库操作。

4.4 参数传递和验证

分区体系结构对于应用程序开发人员应该相对透明。该体系结构应执行与在分区模式下运行应用程序相关的所有任务,包括:

- 在应用程序启动之前检索分区参数

- 在应用程序启动之前验证分区参数

- 在启动时将参数传递给应用程序

验证应包括检查以确保:

- 该应用程序具有足够的分区来覆盖整个数据范围

- 分区之间没有间隙

如果数据库已分区,则可能需要进行一些其他验证,以确保单个分区不会跨越数据库分区。

此外,体系结构还应考虑分区的合并。关键问题包括:

- 在进入下一个作业步骤之前,是否必须完成所有分区?

- 如果其中一个分区中止会怎样?

2. Spring Batch 3.0 的新功能

Spring Batch 3.0 版本具有五个主要主题:

- JSR-352 Support

- 升级以支持 Spring 4 和 Java 8

- 将 Spring Batch 集成到 Spring Batch

- JobScope Support

- SQLite Support

2.1 JSR-352 支持

JSR-352 是用于批处理的新 Java 规范。受 Spring Batch 的启发,此规范提供了与 Spring Batch 已支持的功能类似的功能。但是,Spring Batch 3.0 已经实现了该规范,并且现在支持符合该标准的批处理作业的定义。使用 JSR-352 的作业规范语言(JSL)配置的批处理作业示例如下所示:

<?xml version="1.0" encoding="UTF-8"?>

<job id="myJob3" xmlns="http://xmlns.jcp.org/xml/ns/javaee" version="1.0">

<step id="step1" >

<batchlet ref="testBatchlet" />

</step>

</job>

有关更多详细信息,请参见第JSR-352 Support节。

2.2 将 Spring Batch 集成到 Spring Batch

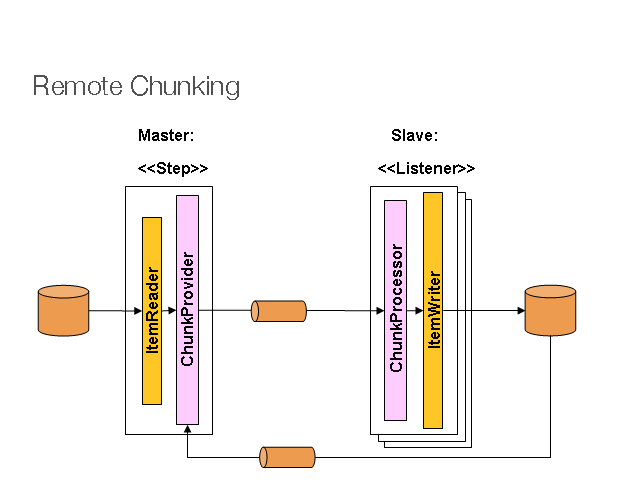

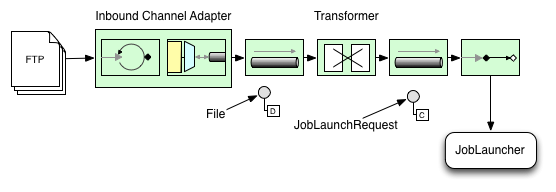

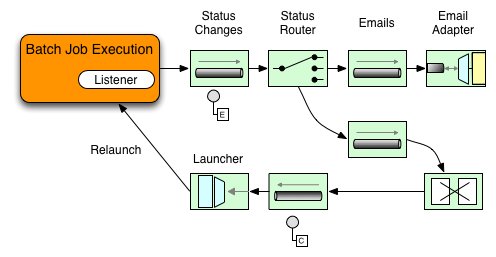

数年来,Spring Batch 集成一直是 Spring Batch AdminItem 的子模块。它提供的功能可以更好地集成 Spring Integration 和 Spring Batch 中提供的功能。具体功能包括:

- 通过消息启动作业

- 异步

ItemProcessors - 提供信息消息反馈

- 通过远程分区和远程组块外部化批处理执行

有关详细信息,请参见第Spring 批处理集成节。

2.3 升级以支持 Spring 4 和 Java 8

随着将 Spring Batch Integration 提升为 Spring BatchItem 的模块,已对其进行了更新以使用 Spring Integration4.SpringIntegration 4 将核心消息传递 API 移至了 Spring 核心。因此,Spring Batch 3 现在将需要 Spring 4 或更高版本。

作为此主要版本中发生的依赖关系更新的一部分,Spring Batch 现在支持在 Java 8 上运行。它仍将在 Java 6 或更高版本上执行。

2.4 JobScope 支持

Spring Batch 中使用的 Spring 作用域“步骤”在批处理应用程序中起着举足轻重的作用,长期以来提供后期绑定功能。在 3.0 版本中,Spring Batch 现在支持“作业”范围。这个新范围允许延迟构造对象,直到实际启动 Job 为止,并为每次执行 Job 的新实例提供便利。您可以在第 5.4.2 节“工作范围”部分中阅读有关此新 bean 范围的详细信息。

2.5 SQLite 支持

通过为 SQLite 添加作业存储库 ddl,已为JobRepository添加了 SQLite 作为新支持的数据库选项。这提供了一个有用的,基于文件的数据存储以用于测试。

1. Spring Batch 4.1 的新增功能

Spring Batch 4.1 版本增加了以下功能:

- 新的

@SpringBatchTestComments 可简化批处理组件的测试 - 新的

@EnableBatchIntegrationComments 可简化远程组块和分区配置 - 新的

JsonItemReader和JsonFileItemWriter支持 JSON 格式 - 添加对使用 Bean 验证 API 验证 Item 的支持

- 添加对 JSR-305Comments 的支持

FlatFileItemWriterBuilderAPI 的增强功能

1.1. @SpringBatchTest 注解

Spring Batch 提供了一些不错的 Util 类(例如JobLauncherTestUtils和JobRepositoryTestUtils)和测试执行监听器(StepScopeTestExecutionListener和JobScopeTestExecutionListener)来测试批处理组件。但是,为了使用这些 Util,必须显式配置它们。此版本引入了一个名为@SpringBatchTest的新 Comments,该 Comments 会自动将 Utilbean 和侦听器添加到测试上下文中,并使它们可用于自动装配,如以下示例所示:

@RunWith(SpringRunner.class)

@SpringBatchTest

@ContextConfiguration(classes = {JobConfiguration.class})

public class JobTest {

@Autowired

private JobLauncherTestUtils jobLauncherTestUtils;

@Autowired

private JobRepositoryTestUtils jobRepositoryTestUtils;

@Before

public void clearMetadata() {

jobRepositoryTestUtils.removeJobExecutions();

}

@Test

public void testJob() throws Exception {

// given

JobParameters jobParameters =

jobLauncherTestUtils.getUniqueJobParameters();

// when

JobExecution jobExecution =

jobLauncherTestUtils.launchJob(jobParameters);

// then

Assert.assertEquals(ExitStatus.COMPLETED,

jobExecution.getExitStatus());

}

}

有关此新 Comments 的更多详细信息,请参见Unit Testing章。

1.2. @EnableBatchIntegration 注解

设置远程分块作业需要定义许多 bean:

- 连接工厂,用于从消息传递中间件(JMS,AMQP 等)获取连接

MessagingTemplate,以将请求从主服务器发送到 Worker,然后再次返回- Spring Integration 从消息传递中间件获取消息的 Importing 通道和输出通道

- 主端的特殊 Item 编写器(

ChunkMessageChannelItemWriter)知道如何将数据块发送给工作人员进行处理和写入 - 工 Writer 方的消息侦听器(

ChunkProcessorChunkHandler)从主服务器接收数据

乍一 Watch 这可能有些令人生畏。此版本引入了名为@EnableBatchIntegration的新 Comments 以及新的 API(RemoteChunkingMasterStepBuilder和RemoteChunkingWorkerBuilder)以简化配置。以下示例显示了如何使用新的 Comments 和 API:

@Configuration

@EnableBatchProcessing

@EnableBatchIntegration

public class RemoteChunkingAppConfig {

@Autowired

private RemoteChunkingMasterStepBuilderFactory masterStepBuilderFactory;

@Autowired

private RemoteChunkingWorkerBuilder workerBuilder;

@Bean

public TaskletStep masterStep() {

return this.masterStepBuilderFactory

.get("masterStep")

.chunk(100)

.reader(itemReader())

.outputChannel(outgoingRequestsToWorkers())

.inputChannel(incomingRepliesFromWorkers())

.build();

}

@Bean

public IntegrationFlow worker() {

return this.workerBuilder

.itemProcessor(itemProcessor())

.itemWriter(itemWriter())

.inputChannel(incomingRequestsFromMaster())

.outputChannel(outgoingRepliesToMaster())

.build();

}

// Middleware beans setup omitted

}

这个新的 Comments 和构建器负责配置基础结构 Bean 的繁重工作。现在,您可以在工作端轻松配置一个主步骤以及一个 Spring Integration 流程。您可以在samples module中找到使用这些新 API 的远程分块示例,并在Spring 批处理集成一章中找到更多详细信息。

就像简化了远程组块配置一样,此版本还引入了新的 API 来简化远程分区设置:RemotePartitioningMasterStepBuilder和RemotePartitioningWorkerStepBuilder。如果存在@EnableBatchIntegration,则可以在配置类中自动连接它们,如以下示例所示:

@Configuration

@EnableBatchProcessing

@EnableBatchIntegration

public class RemotePartitioningAppConfig {

@Autowired

private RemotePartitioningMasterStepBuilderFactory masterStepBuilderFactory;

@Autowired

private RemotePartitioningWorkerStepBuilderFactory workerStepBuilderFactory;

@Bean

public Step masterStep() {

return this.masterStepBuilderFactory

.get("masterStep")

.partitioner("workerStep", partitioner())

.gridSize(10)

.outputChannel(outgoingRequestsToWorkers())

.inputChannel(incomingRepliesFromWorkers())

.build();

}

@Bean

public Step workerStep() {

return this.workerStepBuilderFactory

.get("workerStep")

.inputChannel(incomingRequestsFromMaster())

.outputChannel(outgoingRepliesToMaster())

.chunk(100)

.reader(itemReader())

.processor(itemProcessor())

.writer(itemWriter())

.build();

}

// Middleware beans setup omitted

}

您可以在Spring 批处理集成章中找到有关这些新 API 的更多详细信息。

1.3. JSON 支持

Spring Batch 4.1 添加了对 JSON 格式的支持。此版本引入了一个新的 Item 读取器,它可以读取以下格式的 JSON 资源:

[

{

"isin": "123",

"quantity": 1,

"price": 1.2,

"customer": "foo"

},

{

"isin": "456",

"quantity": 2,

"price": 1.4,

"customer": "bar"

}

]

与 XML 的StaxEventItemReader相似,新的JsonItemReader使用流 API 读取大块的 JSON 对象。 Spring Batch 支持两个库:

要添加其他库,您可以实现JsonObjectReader接口。

JsonFileItemWriter还支持写入 JSON 数据。有关 JSON 支持的更多详细信息,请参见ItemReaders 和 ItemWriters章。

1.4. Bean 验证 API 支持

此版本带来了一个名为BeanValidatingItemProcessor的新ValidatingItemProcessor实现,它使您可以验证使用 Bean Validation API(JSR-303)注解进行注解的 Item。例如,给定以下类型Person:

class Person {

@NotEmpty

private String name;

public Person(String name) {

this.name = name;

}

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

}

您可以通过在应用程序上下文中声明BeanValidatingItemProcessor bean 来验证 Item,并在面向块的步骤中将其注册为处理器:

@Bean

public BeanValidatingItemProcessor<Person> beanValidatingItemProcessor() throws Exception {

BeanValidatingItemProcessor<Person> beanValidatingItemProcessor = new BeanValidatingItemProcessor<>();

beanValidatingItemProcessor.setFilter(true);

return beanValidatingItemProcessor;

}

1.5. JSR-305 支持

此版本增加了对 JSR-305 注解的支持。它利用 Spring Framework 的Null-safetyComments,并将它们添加到 Spring Batch 的所有公共 API 上。

这些注解不仅将在使用 Spring Batch API 时强制执行空安全性,而且还可以被 IDE 用于提供与空性有关的有用信息。例如,如果用户要实现ItemReader接口,则任何支持 JSR-305 注解的 IDE 都会生成以下内容:

public class MyItemReader implements ItemReader<String> {

@Nullable

public String read() throws Exception {

return null;

}

}

read方法中出现的@NullableComments 清楚表明此方法的约定表明它可能返回null。这将强制执行其 Javadoc 中所说的read方法在数据源耗尽时应返回null。

1.6. FlatFileItemWriterBuilder 增强功能

此版本中添加的另一个小功能是简化了写入平面文件的配置。特别是,这些更新简化了定界文件和定宽文件的配置。以下是更改前后的示例。

// Before

@Bean

public FlatFileItemWriter<Item> itemWriter(Resource resource) {

BeanWrapperFieldExtractor<Item> fieldExtractor =

new BeanWrapperFieldExtractor<Item>();

fieldExtractor.setNames(new String[] {"field1", "field2", "field3"});

fieldExtractor.afterPropertiesSet();

DelimitedLineAggregator aggregator = new DelimitedLineAggregator();

aggregator.setFieldExtractor(fieldExtractor);

aggregator.setDelimiter(";");

return new FlatFileItemWriterBuilder<Item>()

.name("itemWriter")

.resource(resource)

.lineAggregator(aggregator)

.build();

}

// After

@Bean

public FlatFileItemWriter<Item> itemWriter(Resource resource) {

return new FlatFileItemWriterBuilder<Item>()

.name("itemWriter")

.resource(resource)

.delimited()

.delimiter(";")

.names(new String[] {"field1", "field2", "field3"})

.build();

}

3. 批处理的域语言

对于任何经验丰富的批处理设计师来说,Spring Batch 中使用的批处理的总体概念应该是熟悉且舒适的。有“作业”和“步骤”,以及开发人员提供的称为 ItemReaders 和 ItemWriters 的处理单元。但是,由于存在 Spring 模式,操作,模板,回调和惯用语,因此有以下机会:

- 遵守明确的关注点方面的重大改进

- 清楚地描述了作为接口提供的体系结构层和服务

- 简单和默认的实现方式,可以快速采用和开箱即用

- 大大增强了可扩展性

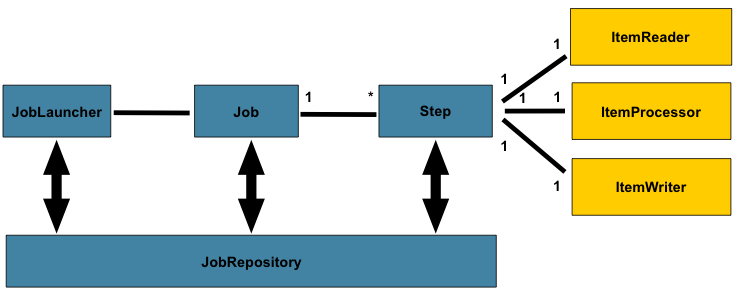

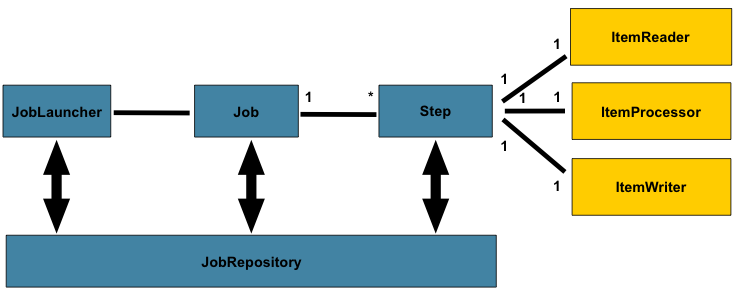

下图是已使用了数十年的批处理参考体系结构的简化版本。它概述了组成批处理领域语言的组件。该体系结构框架是一个蓝图,已经在最后几代平台(COBOL/Mainframe,C/Unix 和现在的 Java /任何地方)上数十年的实现中得到了证明。 JCL 和 COBOL 开发人员可能像 C,C#和 Java 开发人员一样熟悉这些概念。 Spring Batch 提供了层,组件和技术服务的物理实现,这些层,组件和技术服务通常用于强大,可维护的系统中,这些系统用于解决从简单到复杂的批处理应用程序的创建,其基础结构和扩展可以满足非常复杂的处理需求。

图 2.1:批量定型

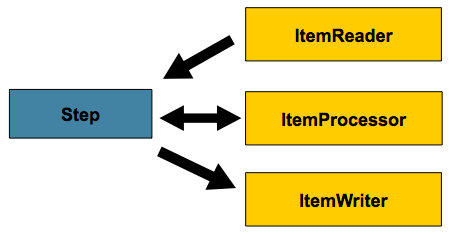

上图突出显示了组成批处理域语言的关键概念。作业有一个到多个步骤,其中只有一个 ItemReader,ItemProcessor 和 ItemWriter。需要启动一个作业(JobLauncher),并且需要存储有关当前正在运行的进程的元数据(JobRepository)。

3.1 Job

本节描述与批处理作业的概念有关的构造型。 Job是封装整个批处理过程的实体。与其他 SpringItem 一样,Job将通过 XML 配置文件或基于 Java 的配置连接在一起。该配置可以被称为“作业配置”。但是,Job只是整体层次结构的顶部:

在 Spring Batch 中,作业只是“步骤”的容器。它组合了逻辑上属于流程的多个步骤,并允许配置所有步骤全局的属性,例如可重新启动性。作业配置包含:

- 工作的简单名称

- 步骤的定义和 Sequences

- 作业是否可重新启动

Spring Batch 以SimpleJob类的形式提供了Job接口的默认简单实现,该类在Job之上创建了一些标准功能,但是 batch 名称空间消除了直接实例化它的需要。而是可以使用<job>标签:

<job id="footballJob">

<step id="playerload" next="gameLoad"/>

<step id="gameLoad" next="playerSummarization"/>

<step id="playerSummarization"/>

</job>

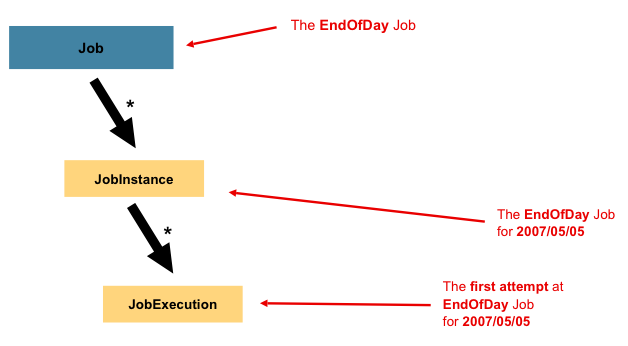

3.1.1 JobInstance

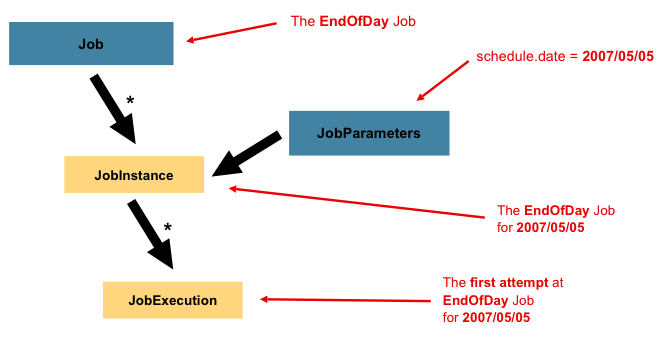

JobInstance表示逻辑作业运行的概念。让我们考虑一个应该在一天结束时运行一次的批处理作业,例如上图中的“ EndOfDay”作业。有一个’EndOfDay’Job,但是必须分别跟踪Job的每个运行。对于这项工作,每天将有一个逻辑JobInstance。例如,将有 1 月 1 日运行和 1 月 2 日运行。如果 1 月 1 日运行第一次失败并在第二天再次运行,则仍是 1 月 1 日运行。 (通常,这也与它正在处理的数据相对应,这意味着 1 月 1 日运行将处理 1 月 1 日的数据,依此类推)。因此,每个JobInstance可以有多个执行(下面将更详细地讨论JobExecution),并且在给定的时间只能运行一个与特定Job并标识JobParameter的JobInstance。

JobInstance的定义绝对与将要加载的数据无关。完全取决于用于确定如何加载数据的ItemReader实现。例如,在 EndOfDay 场景中,数据上可能有一列指示该数据所属的“生效日期”或“计划日期”。因此,1 月 1 日的运行只会加载来自 1 号的数据,而 1 月 2 日的运行只会使用来自 2 号的数据。由于此确定可能是业务决策,因此应由ItemReader来决定。但是,使用相同的JobInstance将确定是否使用先前执行中的“状态”(即下面讨论的ExecutionContext)。使用新的JobInstance表示“从头开始”,而使用现有实例通常表示“从上次中断的地方开始”。

3.1.2 JobParameters

在讨论了JobInstance及其与Job的区别之后,自然要问的问题是:“一个JobInstance与另一个JobInstance有什么区别?”答案是:JobParameters。 JobParameters是用于启动批处理作业的一组参数。在运行期间,它们可以用于标识甚至用作参考数据:

在上面的示例中,有两个实例,一个实例是 1 月 1 日,另一个实例是 1 月 2 日,实际上只有一个 Job,一个实例的工作参数为 01-01-2008,另一个实例的工作参数为。参数 01-02-2008.因此,Contract 可以定义为:JobInstance = Job标识JobParameters。这使开发人员可以有效地控制JobInstance的定义方式,因为他们可以控制传入的参数。

Note

并非所有作业参数都需要有助于JobInstance的标识。默认情况下,它们会这样做,但是该框架允许使用参数也不会对JobInstance的身份作出贡献的Job提交。

3.1.3 JobExecution

JobExecution是指一次尝试运行Job的技术概念。执行可能以失败或成功结束,但是与给定执行相对应的JobInstance不会被视为完成,除非执行成功完成。以上面描述的 EndOfDay Job为例,考虑到 01-01-2008 的JobInstance首次运行失败。如果使用与第一次运行相同的标识作业参数再次运行(01-01-2008),将创建一个新的JobExecution。但是,仍然只有一个JobInstance。

Job定义什么是作业及其执行方式,而JobInstance是纯粹的组织对象,用于将执行分组在一起,主要是为了实现正确的重启语义。 JobExecution是运行期间实际发生情况的主要存储机制,因此包含许多必须控制和持久化的属性:

表 3.1. JobExecution 属性

| status | BatchStatus对象,指示执行状态。运行时为 BatchStatus.STARTED,如果失败,则为 BatchStatus.FAILED,如果成功完成,则为 BatchStatus.COMPLETED。 |

|---|---|

| startTime | java.util.Date代表执行开始时的当前系统时间。 |

| endTime | java.util.Date代表执行完成时的当前系统时间,无论执行是否成功。 |

| exitStatus | ExitStatus表示运行结果。这是最重要的,因为它包含将返回给调用方的退出代码。有关更多详细信息,请参见第 5 章。 |

| createTime | java.util.Date代表首次保留JobExecution时的当前系统时间。作业可能尚未启动(因此没有启动时间),但是它将始终具有 createTime,这是 Management 作业级别ExecutionContext的框架所要求的。 |

| lastUpdated | java.util.Date代表上一次保留JobExecution的时间。 |

| executionContext | “属性袋”包含两次执行之间需要保留的所有用户数据。 |

| failureExceptions | 在执行Job时遇到的异常列表。如果在Job失败期间遇到多个异常,这些将很有用。 |

这些属性很重要,因为它们将被保留并可以用来完全确定执行状态。例如,如果 01-01 的 EndOfDay 作业在晚上 9:00 执行,但在 9:30 失败,则将在批处理元数据表中进行以下 Importing:

表 3.2. BATCH_JOB_INSTANCE

| JOB_INST_ID | JOB_NAME |

|---|---|

| 1 | EndOfDayJob |

表 3.3. BATCH_JOB_EXECUTION_PARAMS

| JOB_EXECUTION_ID | TYPE_CD | KEY_NAME | DATE_VAL | IDENTIFYING |

|---|---|---|---|---|

| 1 | DATE | schedule.Date | 2008-01-01 | TRUE |

表 3.4. BATCH_JOB_EXECUTION

| JOB_EXEC_ID | JOB_INST_ID | START_TIME | END_TIME | STATUS |

|---|---|---|---|---|

| 1 | 1 | 2008-01-01 21:00 | 2008-01-01 21:30 | FAILED |

Note

为了清楚和格式化,列名可能已缩写或删除

现在,该工作已失败,我们假设确定问题已花费了一整夜,因此现在已关闭“批处理窗口”。假设窗口在 9:00 PM 开始,则该作业将在 01-01 再次开始,从停止的地方开始,并在 9:30 成功完成。因为现在是第二天,所以还必须运行 01-02 作业,此作业随后在 9:31 开始,并在正常的一小时时间内在 10:30 完成。无需先将一个JobInstance依次启动,除非这两个作业有可能尝试访问相同的数据,从而导致锁定数据库级别的问题。何时应运行Job完全取决于调度程序。由于它们是单独的JobInstance,因此 Spring Batch 将不会尝试阻止它们同时运行。 (尝试在另一个已经运行的同一个JobInstance上运行将导致抛出JobExecutionAlreadyRunningException)。 JobInstance和JobParameters表中现在都应该有一个额外的条目,而JobExecution表中应该有两个额外的条目:

表 3.5. BATCH_JOB_INSTANCE

| JOB_INST_ID | JOB_NAME |

|---|---|

| 1 | EndOfDayJob |

| 2 | EndOfDayJob |

表 3.6. BATCH_JOB_EXECUTION_PARAMS

| JOB_EXECUTION_ID | TYPE_CD | KEY_NAME | DATE_VAL | IDENTIFYING |

|---|---|---|---|---|

| 1 | DATE | schedule.Date | 2008-01-01 00:00:00 | TRUE |

| 2 | DATE | schedule.Date | 2008-01-01 00:00:00 | TRUE |

| 3 | DATE | schedule.Date | 2008-01-02 00:00:00 | TRUE |

表 3.7. BATCH_JOB_EXECUTION

| JOB_EXEC_ID | JOB_INST_ID | START_TIME | END_TIME | STATUS |

|---|---|---|---|---|

| 1 | 1 | 2008-01-01 21:00 | 2008-01-01 21:30 | FAILED |

| 2 | 1 | 2008-01-02 21:00 | 2008-01-02 21:30 | COMPLETED |

| 3 | 2 | 2008-01-02 21:31 | 2008-01-02 22:29 | COMPLETED |

Note

为了清楚和格式化,列名可能已缩写或删除

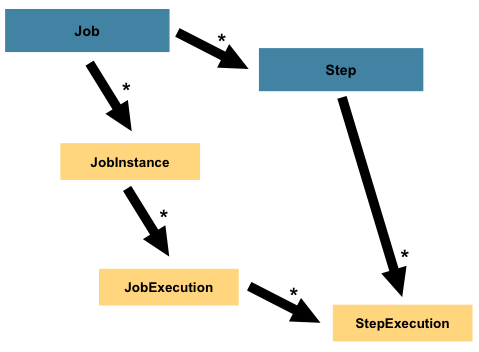

3.2 Step

Step是一个域对象,它封装了批处理作业的一个独立的 Sequences 阶段。因此,每个Job完全由一个或多个步骤组成。 Step包含定义和控制实际批处理所需的所有信息。这是一个模糊的描述,因为任何给定Step的内容都由开发人员自行编写Job来决定。步骤可以像开发人员所希望的那样简单或复杂。一个简单的Step可能会将文件中的数据加载到数据库中,几乎不需要代码。 (取决于所使用的实现方式)较复杂的Step可能具有复杂的业务规则,这些规则将在处理过程中应用。与Job一样,Step的个人StepExecution与唯一的JobExecution相对应:

3.2.1 StepExecution

StepExecution代表执行Step的单次尝试。每次运行Step都会创建一个新的StepExecution,类似于JobExecution。但是,如果某个步骤由于执行失败而无法执行,则该执行将不会 continue 执行。 StepExecution仅在其Step实际启动时创建。

步骤执行由StepExecution类的对象表示。每个执行都包含对其相应步骤和JobExecution的引用,以及与事务相关的数据,例如提交和回滚计数以及开始和结束时间。此外,每个步骤执行都将包含ExecutionContext,其中包含开发人员在批处理运行期间需要保留的任何数据,例如重新启动所需的统计信息或状态信息。以下是StepExecution的属性列表:

表 3.8. StepExecution 属性

| status | BatchStatus对象,指示执行状态。运行时,状态为 BatchStatus.STARTED,如果失败,则状态为 BatchStatus.FAILED,如果成功完成,则状态为 BatchStatus.COMPLETED |

|---|---|

| startTime | java.util.Date代表执行开始时的当前系统时间。 |

| endTime | java.util.Date代表执行完成时的当前系统时间,无论执行是否成功。 |

| exitStatus | ExitStatus表示执行结果。这是最重要的,因为它包含将返回给调用方的退出代码。有关更多详细信息,请参见第 5 章。 |

| executionContext | “属性袋”包含两次执行之间需要保留的所有用户数据。 |

| readCount | 已成功读取的 Item 数 |

| writeCount | 已成功写入的 Item 数 |

| commitCount | 为此执行已提交的事务数 |

| rollbackCount | Step控制的业务事务已回滚的次数。 |

| readSkipCount | read失败的次数,导致 Item 被跳过。 |

| processSkipCount | process失败的次数,导致 Item 被跳过。 |

| filterCount | ItemProcessor已“过滤”的 Item 数。 |

| writeSkipCount | write失败的次数,导致 Item 被跳过。 |

3.3 ExecutionContext

ExecutionContext表示键/值对的集合,这些键/值对由框架保留并控制,以便允许开发人员放置一个存储范围为StepExecution或JobExecution的持久状态。对于熟悉 Quartz 的人来说,它与JobDataMap非常相似。最佳用法示例是促进重新启动。以平面文件 Importing 为例,在处理各个行时,框架会定期在提交点保留ExecutionContext。如果运行期间发生致命错误,或者即使断电,这也允许ItemReader存储其状态。需要做的就是将当前读取的行数放入上下文中,框架将完成其余工作:

executionContext.putLong(getKey(LINES_READ_COUNT), reader.getPosition());

以 Job Stereotypes 部分的 EndOfDay 示例为例,假设有一个步骤:“ loadData”,它将文件加载到数据库中。第一次失败运行后,元数据表将如下所示:

表 3.9. BATCH_JOB_INSTANCE

| JOB_INST_ID | JOB_NAME |

|---|---|

| 1 | EndOfDayJob |

表 3.10. BATCH_JOB_PARAMS

| JOB_INST_ID | TYPE_CD | KEY_NAME | DATE_VAL |

|---|---|---|---|

| 1 | DATE | schedule.Date | 2008-01-01 |

表 3.11. BATCH_JOB_EXECUTION

| JOB_EXEC_ID | JOB_INST_ID | START_TIME | END_TIME | STATUS |

|---|---|---|---|---|

| 1 | 1 | 2008-01-01 21:00 | 2008-01-01 21:30 | FAILED |

表 3.12. BATCH_STEP_EXECUTION

| STEP_EXEC_ID | JOB_EXEC_ID | STEP_NAME | START_TIME | END_TIME | STATUS |

|---|---|---|---|---|---|

| 1 | 1 | loadDate | 2008-01-01 21:00 | 2008-01-01 21:30 | FAILED |

表 3.13. BATCH_STEP_EXECUTION_CONTEXT

| STEP_EXEC_ID | SHORT_CONTEXT |

|---|---|

| 1 | {piece.count=40321} |

在这种情况下,Step运行了 30 分钟并处理了 40321 个“件”,在这种情况下,这代表了文件中的行。此值将在框架每次提交之前更新,并且可以包含与ExecutionContext内的条目相对应的多行。在提交之前被通知需要各种StepListener或ItemStream之一,本指南后面将对此进行详细讨论。与前面的示例一样,假定Job在第二天重新启动。重新启动后,将从数据库中重新构建上次运行的ExecutionContext的值,打开ItemReader时,它可以检查其在上下文中是否具有任何存储状态,并从那里初始化自身:

if (executionContext.containsKey(getKey(LINES_READ_COUNT))) {

log.debug("Initializing for restart. Restart data is: " + executionContext);

long lineCount = executionContext.getLong(getKey(LINES_READ_COUNT));

LineReader reader = getReader();

Object record = "";

while (reader.getPosition() < lineCount && record != null) {

record = readLine();

}

}

在这种情况下,执行上述代码后,当前行将为 40,322,从而允许Step从中断处重新开始。 ExecutionContext还可以用于需要保留有关运行本身的统计信息。例如,如果平面文件包含跨多行存在的处理订单,则可能有必要存储已处理的订单数量(与读取的行数有很大不同),以便可以通过以下方式发送电子邮件: Step的末尾在正文中处理了总订单。框架负责为开发人员存储此内容,以便使用单独的JobInstance正确确定范围。知道是否应使用现有的ExecutionContext可能非常困难。例如,使用上面的“ EndOfDay”示例,当 01-01 运行第二次再次开始时,框架将识别出它是相同的JobInstance,并且在单个Step的基础上,将ExecutionContext从数据库中移出并动手它是StepExecution到Step本身的一部分。相反,对于 01-02 运行,框架会认识到它是一个不同的实例,因此必须将空上下文传递给Step。框架使开发人员做出许多这类确定,以确保在正确的时间将状态提供给开发人员。同样重要的是要注意,在任何给定时间,每个StepExecution仅存在一个ExecutionContext。 ExecutionContext的 Client 应小心,因为这会创建共享的键空间,因此在放入值时应格外小心,以确保不会覆盖任何数据。但是,Step绝对不会在上下文中存储任何数据,因此没有办法对框架产生不利影响。

同样重要的是要注意,每个JobExecution至少有一个ExecutionContext,每个StepExecution至少有一个ExecutionContext。例如,考虑以下代码片段:

ExecutionContext ecStep = stepExecution.getExecutionContext();

ExecutionContext ecJob = jobExecution.getExecutionContext();

//ecStep does not equal ecJob

如 Comment 中所述,ecStep 将不等于 ecJob;他们是两个不同的ExecutionContext。范围为Step的一个将保存在Step的每个提交点,而范围为Job的一个将保存在每次Step执行之间。

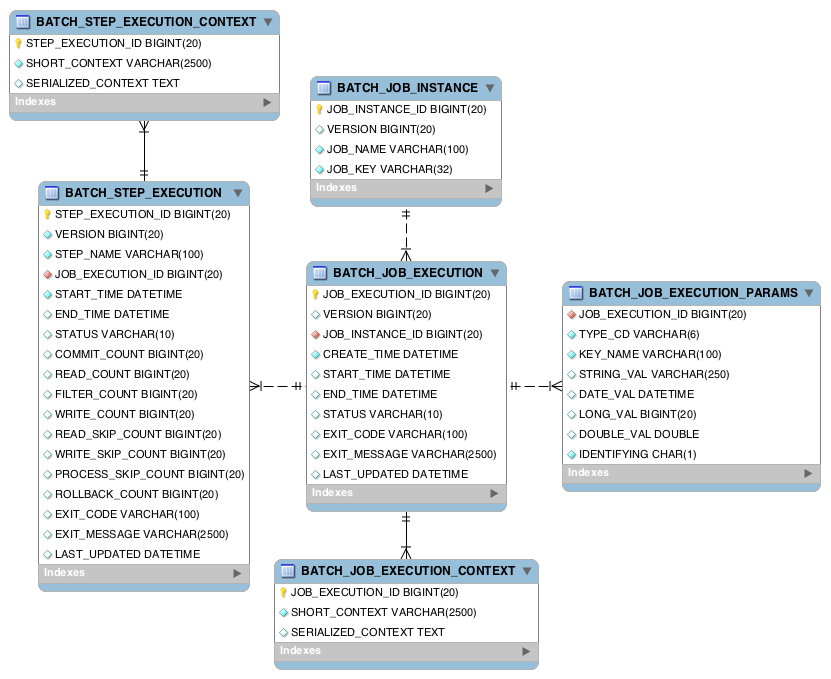

3.4 JobRepository

JobRepository是上述所有构造型的持久性机制。它为JobLauncher,Job和Step实现提供 CRUD 操作。首次启动Job时,会从存储库中获取JobExecution,并且在执行过程中StepExecution和JobExecution的实现通过将其传递到存储库中而得以保留:

<job-repository id="jobRepository"/>

3.5 JobLauncher

JobLauncher代表一个简单的界面,用于使用给定的JobParameters集启动Job:

public interface JobLauncher {

public JobExecution run(Job job, JobParameters jobParameters)

throws JobExecutionAlreadyRunningException, JobRestartException;

}

预期实现将从JobRepository获得有效的JobExecution并执行Job。

3.6itemReader

ItemReader是一种抽象,表示一次检索Step的 Importing。当ItemReader用尽了它可以提供的 Item 时,它将通过返回 null 来表明这一点。可以在第 6 章,ItemReader 和 ItemWriters中找到有关ItemReader接口及其各种实现的更多详细信息。

3.7ItemWriter

ItemWriter是一个抽象,表示一次Step,一个批次或大块 Item 的输出。通常,ItemWriter 不知道下一步将要接收的 Importing,仅知道在当前调用中传递的 Item。有关ItemWriter接口及其各种实现的更多详细信息,可以在第 6 章,ItemReader 和 ItemWriters中找到。

3.8Item 处理器

ItemProcessor是表示 Item 的业务处理的抽象。 ItemReader读取一项,ItemWriter写入一项,而ItemProcessor提供访问权以进行转换或应用其他业务处理。如果在处理 Item 时确定该 Item 无效,则返回 null 表示不应将该 Item 写出。有关 ItemProcessor 接口的更多详细信息,请参见第 6 章,ItemReader 和 ItemWriters。

3.9 批处理命名空间

上面列出的许多域概念都需要在 Spring ApplicationContext中进行配置。尽管可以在标准 bean 定义中使用上述接口的实现,但提供了命名空间以简化配置:

<beans:beans xmlns="http://www.springframework.org/schema/batch"

xmlns:beans="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="

http://www.springframework.org/schema/beans

http://www.springframework.org/schema/beans/spring-beans.xsd

http://www.springframework.org/schema/batch

http://www.springframework.org/schema/batch/spring-batch-2.2.xsd">

<job id="ioSampleJob">

<step id="step1">

<tasklet>

<chunk reader="itemReader" writer="itemWriter" commit-interval="2"/>

</tasklet>

</step>

</job>

</beans:beans>

只要声明了批处理名称空间,就可以使用其任何元素。有关配置Job的更多信息,请参见第 4 章,配置和运行作业。可以在第 5 章,配置步骤中找到有关配置步骤的更多信息。

4. 配置和运行作业

在domain section中,使用下图作为指南讨论了总体体系结构设计:

尽管Job对象似乎是简单的步骤容器,但是开发人员必须了解许多配置选项。此外,对于Job将如何运行以及在此运行期间如何存储其元数据有许多考虑因素。本章将解释Job的各种配置选项和运行时问题。

4.1 配置作业

Job接口有多种实现,但是,名称空间抽象了配置上的差异。它仅具有三个必需的依赖项:名称JobRepository和Step的列表。

<job id="footballJob">

<step id="playerload" parent="s1" next="gameLoad"/>

<step id="gameLoad" parent="s2" next="playerSummarization"/>

<step id="playerSummarization" parent="s3"/>

</job>

这里的示例使用父 bean 定义来创建步骤。有关内联声明特定步骤详细信息的更多选项,请参见step configuration部分。 XML 名称空间默认引用 ID 为’jobRepository’的存储库,这是明智的默认设置。但是,可以显式覆盖:

<job id="footballJob" job-repository="specialRepository">

<step id="playerload" parent="s1" next="gameLoad"/>

<step id="gameLoad" parent="s3" next="playerSummarization"/>

<step id="playerSummarization" parent="s3"/>

</job>

除了步骤之外,作业配置还可以包含其他有助于并行化(<split/>),声明性流控制(<decision/>)和流定义外部化(<flow/>)的元素。

4.1.1 Restartability

执行批处理作业时的一个关键问题与Job重新启动时的行为有关。如果特定JobInstance已经存在JobExecution,则启动Job被认为是“重新启动”。理想情况下,所有作业都应该能够从中断的地方开始,但是在某些情况下这是不可能的。 在这种情况下,完全由开发人员决定是否创建新的JobInstance 。但是,Spring Batch 确实提供了一些帮助。如果Job绝不应该重新启动,而应始终作为新JobInstance的一部分运行,则可重新启动属性可以设置为’false’:

<job id="footballJob" restartable="false">

...

</job>

换句话说,将 restartable 设置为 false 意味着“此作业不支持再次启动”。重新启动无法重新启动的作业将导致抛出JobRestartException:

Job job = new SimpleJob();

job.setRestartable(false);

JobParameters jobParameters = new JobParameters();

JobExecution firstExecution = jobRepository.createJobExecution(job, jobParameters);

jobRepository.saveOrUpdate(firstExecution);

try {

jobRepository.createJobExecution(job, jobParameters);

fail();

}

catch (JobRestartException e) {

// expected

}

这个 JUnit 代码片段显示了第一次为不可重新启动的job创建JobExecution不会造成任何问题。但是,第二次尝试将抛出JobRestartException。

4.1.2 拦截作业执行

在执行Job的过程中,通知其生命周期中的各种事件可能很有用,以便可以执行自定义代码。 SimpleJob通过在适当的时间调用JobListener来实现此目的:

public interface JobExecutionListener {

void beforeJob(JobExecution jobExecution);

void afterJob(JobExecution jobExecution);

}

可以通过作业上的 listeners 元素将JobListener s 添加到SimpleJob:

<job id="footballJob">

<step id="playerload" parent="s1" next="gameLoad"/>

<step id="gameLoad" parent="s2" next="playerSummarization"/>

<step id="playerSummarization" parent="s3"/>

<listeners>

<listener ref="sampleListener"/>

</listeners>

</job>

应该注意的是,无论Job是成功还是失败,都将调用afterJob。如果需要确定成功或失败,可以从JobExecution获得:

public void afterJob(JobExecution jobExecution){

if( jobExecution.getStatus() == BatchStatus.COMPLETED ){

//job success

}

else if(jobExecution.getStatus() == BatchStatus.FAILED){

//job failure

}

}

与此接口对应的 Comments 为:

@BeforeJob@AfterJob

4.1.3 从父作业继承

如果一组Job共享相似但不相同的配置,则定义“父” Job可能会有所帮助,具体的Job可以从中继承属性。类似于 Java 中的类继承,“子” Job将其元素和属性与父类结合在一起。

在下面的示例中,“ baseJob”是一个抽象的Job定义,仅定义一个侦听器列表。 Job“ job1”是一个具体的定义,它继承了“ baseJob”的侦听器列表,并将其与自己的侦听器列表合并,以产生带有两个侦听器和一个Step的Job,即“ step1”。

<job id="baseJob" abstract="true">

<listeners>

<listener ref="listenerOne"/>

<listeners>

</job>

<job id="job1" parent="baseJob">

<step id="step1" parent="standaloneStep"/>

<listeners merge="true">

<listener ref="listenerTwo"/>

<listeners>

</job>

有关更多详细信息,请参见从父步骤继承部分。

4.1.4 JobParametersValidator

在 XML 名称空间中声明的作业或使用 AbstractJob 的任何子类声明的作业可以选择在运行时声明作业参数的验证器。例如,当您需要 assert 一个作业使用其所有必填参数启动时,此功能很有用。有一个 DefaultJobParametersValidator 可用于约束简单的强制性和可选参数的组合,对于更复杂的约束,您可以自己实现接口。 XML 名称空间通过作业的子元素来支持验证器的配置,例如:

<job id="job1" parent="baseJob3">

<step id="step1" parent="standaloneStep"/>

<validator ref="paremetersValidator"/>

</job>

可以将验证器指定为引用(如上)或在 bean 名称空间中作为嵌套 bean 定义。

4.2 Java 配置

Spring 3 带来了通过 Java 而不是 XML 配置应用程序的功能。从 Spring Batch 2.2.0 开始,可以使用相同的 Java 配置来配置批处理作业。基于 Java 的配置有两个组件:@EnableBatchConfigurationComments 和两个构建器。

@EnableBatchProcessing的工作方式与 Spring 家族中其他@Enable*的 Comments 类似。在这种情况下,@EnableBatchProcessing提供了用于构建批处理作业的基本配置。在此基本配置中,除了提供许多可自动装配的 bean 之外,还创建了StepScope的实例:

JobRepository-Bean 名称“ jobRepository”JobLauncher-Bean 名称“ jobLauncher”JobRegistry-Bean 名称“ jobRegistry”PlatformTransactionManager-Bean 名称“ transactionManager”JobBuilderFactory-Bean 名称为“ jobBuilders”StepBuilderFactory-Bean 名称为“ stepBuilders”

此配置的核心接口是BatchConfigurer。默认实现提供上面提到的 bean,并且在要提供的上下文中需要DataSource作为 bean。 JobRepository将使用此数据源。

Note

只有一个配置类需要具有@EnableBatchProcessingComments。在为类加上 Comments 后,您将可以使用上述所有内容。

使用基本配置后,用户可以使用提供的构建器工厂来配置作业。以下是通过JobBuilderFactory和StepBuilderFactory配置的两步作业的示例。

@Configuration

@EnableBatchProcessing

@Import(DataSourceConfiguration.class)

public class AppConfig {

@Autowired

private JobBuilderFactory jobs;

@Autowired

private StepBuilderFactory steps;

@Bean

public Job job(@Qualifier("step1") Step step1, @Qualifier("step2") Step step2) {

return jobs.get("myJob").start(step1).next(step2).build();

}

@Bean

protected Step step1(ItemReader<Person> reader, ItemProcessor<Person, Person> processor, ItemWriter<Person> writer) {

return steps.get("step1")

.<Person, Person> chunk(10)

.reader(reader)

.processor(processor)

.writer(writer)

.build();

}

@Bean

protected Step step2(Tasklet tasklet) {

return steps.get("step2")

.tasklet(tasklet)

.build();

}

}

4.3 配置 JobRepository

如前所述,JobRepository用于 Spring Batch 中各种持久化域对象(例如JobExecution和StepExecution)的基本 CRUD 操作。许多主要框架功能都需要它,例如JobLauncher,Job和Step。批处理名称空间抽象了JobRepository实现及其协 Writer 的许多实现细节。但是,仍然有一些可用的配置选项:

<job-repository id="jobRepository"

data-source="dataSource"

transaction-manager="transactionManager"

isolation-level-for-create="SERIALIZABLE"

table-prefix="BATCH_"

max-varchar-length="1000"/>

除了 ID 以外,上面列出的所有配置选项都不是必需的。如果未设置,将使用上面显示的默认值。出于认知目的,它们在上面显示。 max-varchar-length默认为 2500,这是samples 模式脚本中长VARCHAR列的长度

用于存储退出代码说明之类的内容。如果您不修改架构并且不使用多字节字符,则无需更改它。

4.3.1 JobRepository 的事务配置

如果使用名称空间,则将在存储库周围自动创建事务建议。这是为了确保正确保留批处理元数据(包括故障后重新启动所需的状态)。如果存储库方法不是事务性的,则框架的行为无法很好地定义。分别指定create*方法属性中的隔离级别,以确保启动作业时,如果两个进程试图同时启动同一作业,则只有一个成功。该方法的默认隔离级别为 SERIALIZABLE,这非常激进:READ_COMMITTED 也可以工作;如果两个进程不太可能以这种方式冲突,则 READ_UNCOMMITTED 会很好。但是,由于对create*方法的调用非常短,因此只要数据库平台支持,SERIALIZED 不太可能引起问题。但是,可以重写:

<job-repository id="jobRepository"

isolation-level-for-create="REPEATABLE_READ" />

如果不使用名称空间或工厂 Bean,那么使用 AOP 配置存储库的事务行为也很重要:

<aop:config>

<aop:advisor

pointcut="execution(* org.springframework.batch.core..*Repository+.*(..))"/>

<advice-ref="txAdvice" />

</aop:config>

<tx:advice id="txAdvice" transaction-manager="transactionManager">

<tx:attributes>

<tx:method name="*" />

</tx:attributes>

</tx:advice>

该片段可以原样使用,几乎没有变化。还记得还要包括适当的名称空间声明,并确保 spring-tx 和 spring-aop(或整个 spring)在 Classpath 中。

4.3.2 更改表前缀

JobRepository的另一个可修改属性是元数据表的表前缀。默认情况下,它们都以 BATCH 开头。 BATCH_JOB_EXECUTION 和 BATCH_STEP_EXECUTION 是两个示例。但是,存在修改此前缀的潜在原因。如果模式名称需要在表名称之前,或者在同一模式内需要一组以上的元数据表,那么表前缀将需要更改:

<job-repository id="jobRepository"

table-prefix="SYSTEM.TEST_" />

鉴于上述更改,对元数据表的每个查询都将以“ SYSTEM.TEST_”为前缀。 BATCH_JOB_EXECUTION 将被称为 SYSTEM.TEST_JOB_EXECUTION。

Note

仅表前缀是可配置的。表名和列名不是。

4.3.3 内存中的存储库

在某些情况下,您可能不想将域对象持久保存到数据库中。原因之一可能是速度。在每个提交点存储域对象会花费额外的时间。另一个原因可能是您不需要为特定工作保留状态。因此,Spring 批处理提供了作业存储库的内存 Map 版本:

<bean id="jobRepository"

class="org.springframework.batch.core.repository.support.MapJobRepositoryFactoryBean">

<property name="transactionManager" ref="transactionManager"/>

</bean>

请注意,内存中的存储库是易失性的,因此不允许在 JVM 实例之间重新启动。它还不能保证同时启动两个具有相同参数的作业实例,并且不适合在多线程 Job 或本地分区的 Step 中使用。因此,在需要这些功能的地方,请使用存储库的数据库版本。

但是,确实需要定义事务 Management 器,因为存储库中存在回滚语义,并且因为业务逻辑可能仍是事务性的(例如 RDBMS 访问)。出于测试目的,许多人认为ResourcelessTransactionManager有用。

4.3.4 存储库中的非标准数据库类型

如果使用的数据库平台不在受支持的平台列表中,并且 SQL 变量足够接近,则可以使用一种受支持的类型。为此,您可以使用原始的JobRepositoryFactoryBean代替名称空间快捷方式,并使用它来将数据库类型设置为最接近的匹配项:

<bean id="jobRepository" class="org...JobRepositoryFactoryBean">

<property name="databaseType" value="db2"/>

<property name="dataSource" ref="dataSource"/>

</bean>

(如果未指定,JobRepositoryFactoryBean会尝试从DataSource自动检测数据库类型.)平台之间的主要差异主要是由增加主键的策略引起的,因此通常也有必要覆盖incrementerFactory (使用 Spring 框架的标准实现之一)。

如果甚至不起作用,或者您没有使用 RDBMS,那么唯一的选择可能是实现SimpleJobRepository所依赖的各种Dao接口,并以正常的 Spring 方式手动将它们连接起来。

4.4 配置 JobLauncher

JobLauncher接口的最基本实现是SimpleJobLauncher。为了获得执行,它唯一需要的依赖项是JobRepository:

<bean id="jobLauncher"

class="org.springframework.batch.core.launch.support.SimpleJobLauncher">

<property name="jobRepository" ref="jobRepository" />

</bean>

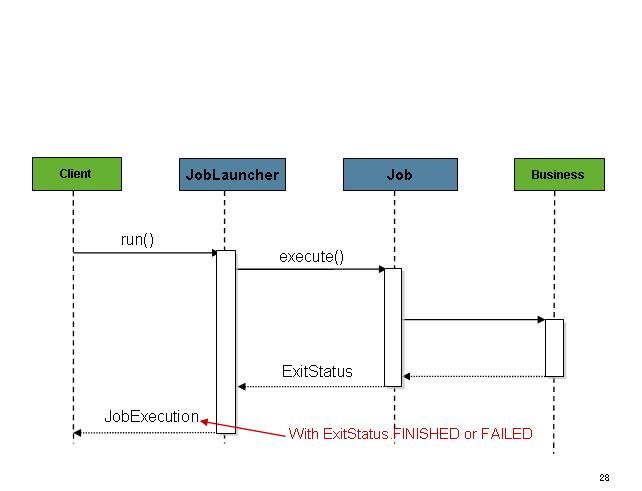

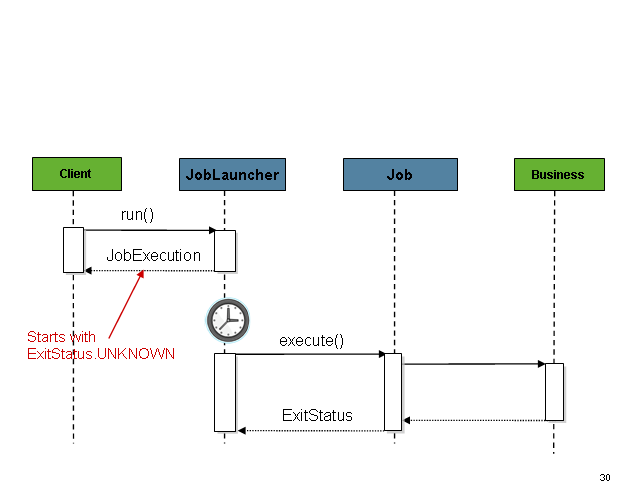

一旦获得JobExecution,它将被传递给Job的 execute 方法,最终将JobExecution返回给调用者:

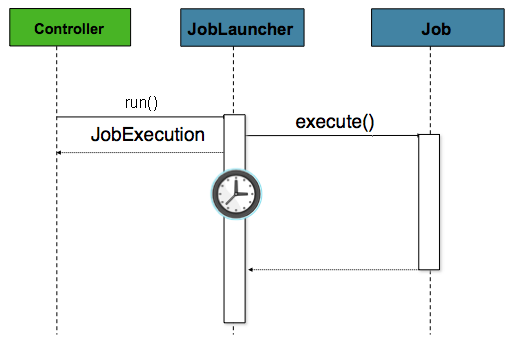

该序列很简单,从调度程序启动时效果很好。但是,尝试从 HTTP 请求启动时会出现问题。在这种情况下,启动需要异步完成,以便SimpleJobLauncher立即返回到其调用方。这是因为在长时间运行的进程(例如批处理)所需的时间内保持 HTTP 请求处于打开状态是一种不好的做法。下面是一个示例序列:

可以通过配置TaskExecutor轻松地将SimpleJobLauncher配置为允许这种情况:

<bean id="jobLauncher"

class="org.springframework.batch.core.launch.support.SimpleJobLauncher">

<property name="jobRepository" ref="jobRepository" />

<property name="taskExecutor">

<bean class="org.springframework.core.task.SimpleAsyncTaskExecutor" />

</property>

</bean>

spring TaskExecutor接口的任何实现都可以用来控制作业的异步执行方式。

4.5 运行作业

至少,启动批处理作业需要两件事:要启动的Job和JobLauncher。两者都可以包含在相同的上下文或不同的上下文中。例如,如果从命令行启动作业,则将为每个作业实例化一个新的 JVM,因此每个作业将具有自己的JobLauncher。但是,如果从HttpRequest范围内的 Web 容器中运行,通常将配置一个JobLauncher用于异步作业启动,多个请求将被调用以启动其作业。

4.5.1 从命令行运行作业

对于想要从企业计划程序运行其作业的用户,命令行是主要界面。这是因为大多数调度程序(除了 Quartz,除非使用NativeJob,否则都是 Quartz 除外)直接与 os 进程一起工作,这些进程主要是从 Shell 脚本开始的。除了 Shell 脚本(例如 Perl,Ruby),甚至还有“构建工具”(例如 ant 或 maven)之外,还有许多启动 Java 进程的方法。但是,由于大多数人都熟悉 Shell 脚本,因此本示例将重点介绍它们。

The CommandLineJobRunner

因为启动作业的脚本必须启动 Java 虚拟机,所以需要一个具有 main 方法的类作为主要入口点。 Spring Batch 提供了一个实现此目的的实现:CommandLineJobRunner。需要特别注意的是,这只是引导应用程序的一种方法,但是有许多方法可以启动 Java 进程,并且绝对不应将此类视为 Authority。 CommandLineJobRunner执行四个任务:

- 加载适当的

ApplicationContext - 将命令行参数解析为

JobParameters - 根据参数找到合适的工作

- 使用应用程序上下文中提供的

JobLauncher启动作业。

所有这些任务仅使用传入的参数即可完成。以下是必填参数:

表 4.1. CommandLineJobRunner 参数

| jobPath | 将用于创建ApplicationContext的 XML 文件的位置。该文件应包含运行完整的Job所需的所有内容 |

|---|---|

| jobName | 要运行的作业的名称。 |

这些参数必须首先以路径和第二个名称传递。这些参数之后的所有参数均视为 JobParameters,并且必须采用“名称=值”的格式:

bash$ java CommandLineJobRunner endOfDayJob.xml endOfDay schedule.date(date)=2007/05/05

在大多数情况下,您可能想使用 Lists 在 jar 中声明您的主类,但为简单起见,直接使用了该类。此示例使用的是domain section中的“ EndOfDay”示例。第一个参数是’endOfDayJob.xml’,它是包含Job的 Spring ApplicationContext。第二个参数’endOfDay’表示作业名称。最后一个参数’schedule.date(date)= 2007/05/05’将转换为JobParameters。 XML 配置示例如下:

<job id="endOfDay">

<step id="step1" parent="simpleStep" />

</job>

<!-- Launcher details removed for clarity -->

<beans:bean id="jobLauncher"

class="org.springframework.batch.core.launch.support.SimpleJobLauncher" />

此示例过于简单,因为通常在 Spring Batch 中运行批处理作业还有更多要求,但是它用于显示CommandLineJobRunner的两个主要要求:Job和JobLauncher

ExitCodes

从命令行启动批处理作业时,通常使用企业计划程序。大多数调度程序都非常笨,只能在流程级别上工作。这意味着他们只知道他们正在调用的某些 os 进程,例如 shell 脚本。在这种情况下,将作业成功或失败传达回调度程序的唯一方法是通过返回码。返回码是由进程返回到调度程序的数字,指示运行结果。在最简单的情况下:0 是成功,1 是失败。但是,可能存在更复杂的方案:如果作业 A 返回 4 个启动作业 B,并且如果作业 5 返回 5 个启动作业 C。这种类型的行为是在调度程序级别配置的,但是诸如 Spring Batch 提供了一种返回特定批处理作业的“退出代码”的数字表示的方法。在 Spring Batch 中,它封装在ExitStatus内,在第 5 章中将进行更详细的介绍。出于讨论退出代码的目的,唯一重要的要知道的是ExitStatus具有由框架设置的退出代码属性(或开发人员),并作为JobLauncher返回的JobExecution的一部分返回。 CommandLineJobRunner使用ExitCodeMapper接口将此字符串值转换为数字:

public interface ExitCodeMapper {

public int intValue(String exitCode);

}

ExitCodeMapper的基本约定是,给定字符串退出代码,将返回数字表示形式。作业运行程序使用的默认实现是 SimpleJvmExitCodeMapper,它对于完成返回 0,对于一般错误返回 1,对于任何作业运行程序错误(例如,无法在提供的上下文中找到Job)返回 2.如果需要比上述 3 个值更复杂的东西,则必须提供ExitCodeMapper接口的自定义实现。由于CommandLineJobRunner是创建ApplicationContext的类,因此无法“连接在一起”,因此必须自动连接任何需要覆盖的值。这意味着,如果在 BeanFactory 中找到ExitCodeMapper的实现,它将在创建上下文后注入到运行器中。提供您自己的ExitCodeMapper所需要做的就是将实现声明为根级 Bean,并确保它是运行程序加载的ApplicationContext的一部分。

4.5.2 从 Web 容器中运行作业

从历史上 Watch,如上所述,已从命令行启动了诸如批处理作业之类的脱机处理。但是,在许多情况下,从HttpRequest启动是更好的选择。许多此类用例包括报告,临时作业运行和 Web 应用程序支持。因为按定义,批处理作业是长期运行的,所以最重要的问题是确保异步启动该作业:

在这种情况下,该控制器是 Spring MVC 控制器。有关 Spring MVC 的更多信息,请参见http://docs.spring.io/spring/docs/3.2.x/spring-framework-reference/html/mvc.html。控制器使用已配置为启动asynchronously的JobLauncher来启动Job,它会立即返回JobExecution。 Job可能仍在运行,但是,这种非阻塞行为允许控制器立即返回,这在处理HttpRequest时是必需的。下面是一个示例:

@Controller

public class JobLauncherController {

@Autowired

JobLauncher jobLauncher;

@Autowired

Job job;

@RequestMapping("/jobLauncher.html")

public void handle() throws Exception{

jobLauncher.run(job, new JobParameters());

}

}

4.6 高级元数据使用

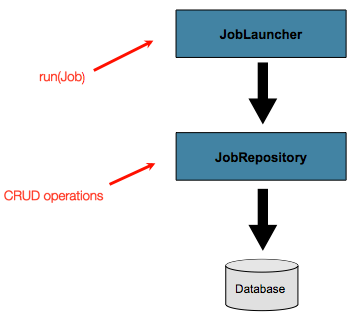

到目前为止,已经讨论了 JobLauncher 和 JobRepository 接口。它们一起代表了作业的简单启动和批处理域对象的基本 CRUD 操作:

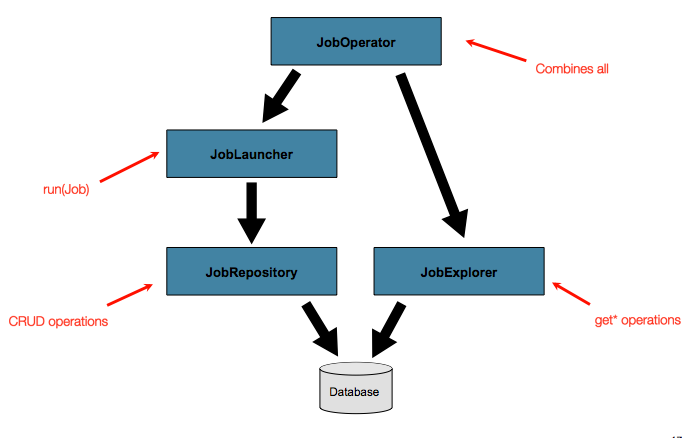

JobLauncher使用JobRepository创建新的JobExecution对象并运行它们。 Job和Step实现稍后在运行Job的过程中使用相同的JobRepository进行相同执行的基本更新。基本操作足以满足简单的场景,但是在具有成百上千个批处理作业和复杂的调度要求的大型批处理环境中,需要对元数据进行更高级的访问:

JobExplorer和JobOperator接口(将在下面进行讨论)添加了用于查询和控制元数据的其他功能。

4.6.1 查询存储库

在使用任何高级功能之前,最基本的需求是能够查询存储库中现有的执行情况。 JobExplorer界面提供了此功能:

public interface JobExplorer {

List<JobInstance> getJobInstances(String jobName, int start, int count);

JobExecution getJobExecution(Long executionId);

StepExecution getStepExecution(Long jobExecutionId, Long stepExecutionId);

JobInstance getJobInstance(Long instanceId);

List<JobExecution> getJobExecutions(JobInstance jobInstance);

Set<JobExecution> findRunningJobExecutions(String jobName);

}

从上面的方法签名可以明显 Watch 出,JobExplorer是JobRepository的只读版本,并且像JobRepository一样,可以通过工厂 bean 轻松配置:

<bean id="jobExplorer" class="org.spr...JobExplorerFactoryBean"

p:dataSource-ref="dataSource" />

本章前面,其中提到可以修改JobRepository的表前缀以允许使用不同的版本或架构。由于JobExplorer使用相同的表,因此它也需要设置前缀的能力:

<bean id="jobExplorer" class="org.spr...JobExplorerFactoryBean"

p:dataSource-ref="dataSource" p:tablePrefix="BATCH_" />

4.6.2 JobRegistry

JobRegistry(及其父接口 JobLocator)不是强制性的,但如果您要跟踪上下文中可用的作业,则可以使用它。当作业在其他位置(例如在子上下文中)创建时,对于在应用程序上下文中集中收集作业也很有用。自定义 JobRegistry 实现也可以用于操纵已注册作业的名称和其他属性。框架仅提供一种实现,该实现基于从作业名称到作业实例的简单 Map。它的配置就像这样:

<bean id="jobRegistry" class="org.spr...MapJobRegistry" />

有两种自动填充 JobRegistry 的方法:使用 bean 后处理器和使用注册商生命周期组件。以下各节将介绍这两种机制。

JobRegistryBeanPostProcessor

这是一个 bean 后处理器,可以在创建所有作业时注册它们:

<bean id="jobRegistryBeanPostProcessor" class="org.spr...JobRegistryBeanPostProcessor">

<property name="jobRegistry" ref="jobRegistry"/>

</bean>

尽管并非严格要求示例中的后处理器具有 ID,以便可以将其包含在子上下文中(例如作为父 Bean 定义),并使在此创建的所有作业也自动进行注册。

AutomaticJobRegistrar

这是一个生命周期组件,它创建子上下文并在创建这些上下文时注册这些上下文中的作业。这样做的优点之一是,尽管子上下文中的作业名称在注册表中仍必须是全局唯一的,但它们的依存关系可以具有“自然”名称。因此,例如,您可以创建一组 XML 配置文件,每个 XML 配置文件仅具有一个Job,但都具有相同 Bean 名称的ItemReader的不同定义,例如“Reader”。如果将所有这些文件都导入到同一上下文中,那么 Reader 定义将相互冲突并相互替代,但是使用自动注册器可以避免这种情况。这使集成由应用程序的单独模块贡献的作业变得更加容易。

<bean class="org.spr...AutomaticJobRegistrar">

<property name="applicationContextFactories">

<bean class="org.spr...ClasspathXmlApplicationContextsFactoryBean">

<property name="resources" value="classpath*:/config/job*.xml" />

</bean>

</property>

<property name="jobLoader">

<bean class="org.spr...DefaultJobLoader">

<property name="jobRegistry" ref="jobRegistry" />

</bean>

</property>

</bean>

注册服务商具有两个必填属性,一个是ApplicationContextFactory的数组(此处是从方便的工厂 bean 创建的),另一个是JobLoader。 JobLoader负责 Management 子上下文的生命周期并在JobRegistry中注册作业。

ApplicationContextFactory负责创建子上下文,最常见的用法是如上使用ClassPathXmlApplicationContextFactory。该工厂的功能之一是默认情况下将某些配置从父上下文复制到子级。因此,例如,如果子代中的PropertyPlaceholderConfigurer或 AOP 配置应与父代相同,则不必重新定义它。

如果需要,可以将AutomaticJobRegistrar与JobRegistryBeanPostProcessor结合使用(只要也使用DefaultJobLoader)。例如,如果在主要父级上下文以及子级位置中定义了作业,则可能需要这样做。

4.6.3 JobOperator

如前所述,JobRepository提供对元数据的 CRUD 操作,而JobExplorer提供对元数据的只读操作。但是,与批处理操作员通常一起使用时,这些操作一起执行常见的监视任务(如停止,重新启动或汇总作业)时最有用。 Spring Batch 通过JobOperator接口提供了这些类型的操作:

public interface JobOperator {

List<Long> getExecutions(long instanceId) throws NoSuchJobInstanceException;

List<Long> getJobInstances(String jobName, int start, int count)

throws NoSuchJobException;

Set<Long> getRunningExecutions(String jobName) throws NoSuchJobException;

String getParameters(long executionId) throws NoSuchJobExecutionException;

Long start(String jobName, String parameters)

throws NoSuchJobException, JobInstanceAlreadyExistsException;

Long restart(long executionId)

throws JobInstanceAlreadyCompleteException, NoSuchJobExecutionException,

NoSuchJobException, JobRestartException;

Long startNextInstance(String jobName)

throws NoSuchJobException, JobParametersNotFoundException, JobRestartException,

JobExecutionAlreadyRunningException, JobInstanceAlreadyCompleteException;

boolean stop(long executionId)

throws NoSuchJobExecutionException, JobExecutionNotRunningException;

String getSummary(long executionId) throws NoSuchJobExecutionException;

Map<Long, String> getStepExecutionSummaries(long executionId)

throws NoSuchJobExecutionException;

Set<String> getJobNames();

}

上面的操作表示来自许多不同接口的方法,例如JobLauncher,JobRepository,JobExplorer和JobRegistry。因此,提供的JobOperator,SimpleJobOperator的实现具有许多依赖性:

<bean id="jobOperator" class="org.spr...SimpleJobOperator">

<property name="jobExplorer">

<bean class="org.spr...JobExplorerFactoryBean">

<property name="dataSource" ref="dataSource" />

</bean>

</property>

<property name="jobRepository" ref="jobRepository" />

<property name="jobRegistry" ref="jobRegistry" />

<property name="jobLauncher" ref="jobLauncher" />

</bean>

Note

如果您在作业存储库上设置了表前缀,请不要忘记也在作业资源 Management 器上进行设置。

4.6.4 JobParametersIncrementer

JobOperator上的大多数方法都是不言自明的,而更详细的解释可以在接口的 javadoc上找到。但是,startNextInstance方法值得注意。此方法将始终启动Job的新实例。如果JobExecution中存在严重问题并且需要从头重新开始Job,这将非常有用。但是与JobLauncher不同,后者需要一个新的JobParameters对象,如果参数与以前的任何一组参数都不相同,该对象将触发新的JobInstance,startNextInstance方法将使用与Job绑定的JobParametersIncrementer来将Job强制为新实例:

public interface JobParametersIncrementer {

JobParameters getNext(JobParameters parameters);

}

JobParametersIncrementer的约定是,给定JobParameters对象,它将通过递增其可能包含的任何必要值来返回“下一个” JobParameters对象。此策略很有用,因为该框架无法知道JobParameters的哪些更改使其成为“下一个”实例。例如,如果JobParameters中唯一的值是日期,并且应该创建下一个实例,那么该值应该增加一天吗?还是一周(例如,如果工作是每周一次)?对于有助于识别Job的任何数值,都可以这样说,如下所示:

public class SampleIncrementer implements JobParametersIncrementer {

public JobParameters getNext(JobParameters parameters) {

if (parameters==null || parameters.isEmpty()) {

return new JobParametersBuilder().addLong("run.id", 1L).toJobParameters();

}

long id = parameters.getLong("run.id",1L) + 1;

return new JobParametersBuilder().addLong("run.id", id).toJobParameters();

}

}

在此示例中,键为“ run.id”的值用于区分JobInstances。如果传入的JobParameters为空,则可以假定Job从未运行过,因此可以返回其初始状态。但是,如果不是,则将获得旧值,将其增加一并返回。增量器可以通过名称空间中的’incrementer’属性与Job关联:

<job id="footballJob" incrementer="sampleIncrementer">

...

</job>

4.6.5 停止作业

JobOperator`最常见的用例之一是正常停止`Job:

Set<Long> executions = jobOperator.getRunningExecutions("sampleJob");

jobOperator.stop(executions.iterator().next());

关闭不是立即关闭的,因为没有办法强制立即关闭,尤其是当执行当前在框架无法控制的开发人员代码中时,例如业务服务。但是,一旦控制权返回到框架,它将把当前StepExecution的状态设置为BatchStatus.STOPPED,保存它,然后对JobExecution进行同样的操作,然后再完成操作。

4.6.6 中止工作

可以重新启动FAILED的作业执行(如果作业是可重新启动的)。框架不会重新启动状态为ABANDONED的作业执行。 ABANDONED状态还用于步骤执行中,以在重新启动的作业执行中将其标记为可跳过:如果作业正在执行,并且在上一个失败的作业执行中遇到了标记为ABANDONED的步骤,它将 continue 进行下一个步骤(由作业流程定义和步骤执行退出状态决定)。

如果进程终止("kill -9"或服务器故障),则该作业当然不会运行,但是 JobRepository 无法知道,因为在进程终止之前没有人告诉过它。您必须手动告诉它,您知道执行失败或应被视为中止(将其状态更改为FAILED或ABANDONED)-这是一项业务决策,无法实现自动化。仅在不可重启或知道重启数据有效时,才将状态更改为FAILED。 Spring Batch Admin JobService中有一个 Util 可中止作业执行。

5. 配置步骤

如批处理域语言所讨论的,Step是一个域对象,该域对象封装了批处理作业的一个独立的 Sequences 阶段,并包含定义和控制实际批处理所需的所有信息。这是一个模糊的描述,因为任何给定Step的内容都由开发人员自行编写Job来决定。步骤可以像开发人员所希望的那样简单或复杂。简单的Step可能会将文件中的数据加载到数据库中,几乎不需要代码。 (取决于所使用的实现方式)较复杂的Step可能具有复杂的业务规则,这些规则将在处理过程中应用。

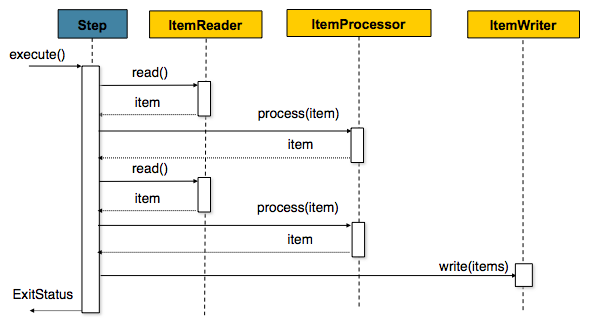

5.1 块处理

Spring Batch 在其最常见的实现中使用“面向块的”处理风格。面向块的处理是指一次读取一个数据,并在事务边界内创建要写出的“块”。从ItemReader读取一项,将其交给ItemProcessor并进行汇总。一旦读取的 Item 数等于提交间隔,就通过 ItemWriter 写入整个块,然后提交事务。

下面是上述相同概念的代码表示:

List items = new Arraylist();

for(int i = 0; i < commitInterval; i++){

Object item = itemReader.read()

Object processedItem = itemProcessor.process(item);

items.add(processedItem);

}

itemWriter.write(items);

5.1.1 配置步骤

尽管Step所需的依赖项列表相对较短,但它是一个极其复杂的类,可能包含许多协 Writer。为了简化配置,可以使用 Spring Batch 名称空间:

<job id="sampleJob" job-repository="jobRepository">

<step id="step1">

<tasklet transaction-manager="transactionManager">

<chunk reader="itemReader" writer="itemWriter" commit-interval="10"/>

</tasklet>

</step>

</job>

上面的配置代表创建面向 Item 的步骤所需的唯一依赖项:

- reader-提供处理 Item 的

ItemReader。 - writer-处理

ItemReader提供的 Item 的ItemWriter。 - transaction-manager-Spring 的

PlatformTransactionManager,将用于在处理期间开始和提交事务。 - job-repository-

JobRepository,将用于在处理过程中(即在提交之前)定期存储StepExecution和ExecutionContext。对于内联\ (在 内定义),它是\ 元素上的一个属性;对于独立步骤,它定义为\ 的属性。 - commit-interval-提交事务之前将要处理的 Item 数。

应当注意,作业存储库默认为“ jobRepository”,而事务 Management 器默认为“ transactionManger”。此外,ItemProcessor是可选的,不是必需的,因为该 Item 可以直接从 Reader 传递给编写器。

5.1.2 从父步骤继承

如果一组Step共享相似的配置,则定义一个“父” Step可能会有所帮助,具体的Step可以从中继承属性。类似于 Java 中的类继承,“子” Step将其元素和属性与父类结合在一起。子代还将覆盖父代的任何Step。

在下面的示例中,Step“ concreteStep1”将从“ parentStep”继承。它将使用’itemReader’,’itemProcessor’,’itemWriter’,startLimit = 5 和 allowStartIfComplete = true 实例化。另外,由于被“ concreteStep1”覆盖,所以 commitInterval 将为“ 5”:

<step id="parentStep">

<tasklet allow-start-if-complete="true">

<chunk reader="itemReader" writer="itemWriter" commit-interval="10"/>

</tasklet>

</step>

<step id="concreteStep1" parent="parentStep">

<tasklet start-limit="5">

<chunk processor="itemProcessor" commit-interval="5"/>

</tasklet>

</step>

在 job 元素内的步骤上,仍然需要 id 属性。这有两个原因:

- 保留 StepExecution 时,该 ID 将用作步骤名称。如果在一个作业中的多个步骤中引用了同一独立步骤,则将发生错误。

- 如本章稍后所述,在创建作业流程时,下一个属性应引用流程中的步骤,而不是独立步骤。

Abstract Step

有时可能有必要定义不是完整的Step配置的父级Step。例如,如果将 Reader,Writer 和 Tasklet 属性保留为Step配置,则初始化将失败。如果必须定义一个没有这些属性的父对象,则应使用“抽象”属性。 “抽象” Step将不会被实例化;它仅用于扩展。

在下面的示例中,如果Step“ abstractParentStep”未声明为抽象,则不会实例化。 Step“ concreteStep2”将具有“ itemReader”,“ itemWriter”和 commitInterval = 10.

<step id="abstractParentStep" abstract="true">

<tasklet>

<chunk commit-interval="10"/>

</tasklet>

</step>

<step id="concreteStep2" parent="abstractParentStep">

<tasklet>

<chunk reader="itemReader" writer="itemWriter"/>

</tasklet>

</step>

Merging Lists

Step上的一些可配置元素是列表;例如,\ 元素。如果父级和子级Step都声明了\ 元素,则子级的列表将覆盖父级的列表。为了允许孩子将其他侦听器添加到 parent 定义的列表中,每个列表元素都具有“合并”属性。如果该元素指定 merge =“ true”,则子级列表将与父级列表合并,而不是覆盖它。

在以下示例中,将创建Step“ concreteStep3”,并将两个侦听器:listenerOne和listenerTwo:

<step id="listenersParentStep" abstract="true">

<listeners>

<listener ref="listenerOne"/>

<listeners>

</step>

<step id="concreteStep3" parent="listenersParentStep">

<tasklet>

<chunk reader="itemReader" writer="itemWriter" commit-interval="5"/>

</tasklet>

<listeners merge="true">

<listener ref="listenerTwo"/>

<listeners>

</step>

5.1.3 提交间隔

如上所述,一个步骤读取和写入 Item,并使用提供的PlatformTransactionManager定期提交。提交间隔为 1 时,它将在写入每个单独的 Item 后提交。在许多情况下,这并不理想,因为开始和提交事务非常昂贵。理想情况下,最好在每个事务中处理尽可能多的 Item,这完全取决于要处理的数据类型和与之交互的资源。因此,可以配置在提交中处理的 Item 数。

<job id="sampleJob">

<step id="step1">

<tasklet>

<chunk reader="itemReader" writer="itemWriter" commit-interval="10"/>

</tasklet>

</step>

</job>

在上面的示例中,每个事务中将处理 10 个 Item。在处理开始时,事务开始,并且每次在ItemReader上调用 read 时,计数器都会递增。当它达到 10 时,聚合项的列表将传递到ItemWriter,事务将被提交。

5.1.4 配置重新启动步骤

在第 4 章,配置和运行作业中,讨论了重新启动Job。重新启动对步骤有很多影响,因此可能需要一些特定的配置。

设置 StartLimit

在许多情况下,您可能希望控制Step的启动次数。例如,可能需要配置特定的Step使其仅运行一次,因为它会使某些必须手动修复的资源无效,然后才能再次运行它。这可以在步骤级别上配置,因为不同的步骤可能有不同的要求。只能执行一次的Step与可以无限运行的Step作为同一Job的一部分存在。以下是启动限制配置示例:

<step id="step1">

<tasklet start-limit="1">

<chunk reader="itemReader" writer="itemWriter" commit-interval="10"/>

</tasklet>

</step>

上面的简单步骤只能运行一次。尝试再次运行它会引发异常。应该注意的是,开始限制的默认值为Integer.MAX_VALUE。

重新开始完成的步骤

对于可重新启动的作业,可能有一个或多个步骤应始终运行,无论它们是否第一次成功。一个示例可能是验证步骤,或者是Step在处理之前清理资源。在正常处理重新启动的作业期间,状态为“已完成”(表示已成功完成)的任何步骤都将被跳过。将 allow-start-if-complete 设置为“ true”将覆盖此设置,以便该步骤将始终运行:

<step id="step1">

<tasklet allow-start-if-complete="true">

<chunk reader="itemReader" writer="itemWriter" commit-interval="10"/>

</tasklet>

</step>

步骤重新启动配置示例

<job id="footballJob" restartable="true">

<step id="playerload" next="gameLoad">

<tasklet>

<chunk reader="playerFileItemReader" writer="playerWriter"

commit-interval="10" />

</tasklet>

</step>

<step id="gameLoad" next="playerSummarization">

<tasklet allow-start-if-complete="true">

<chunk reader="gameFileItemReader" writer="gameWriter"

commit-interval="10"/>

</tasklet>

</step>

<step id="playerSummarization">

<tasklet start-limit="3">

<chunk reader="playerSummarizationSource" writer="summaryWriter"

commit-interval="10"/>

</tasklet>

</step>

</job>

上面的示例配置适用于加载有关足球 match 的信息并对其进行汇总的作业。它包含三个步骤:playerLoad,gameLoad 和 playerSummarization。 playerLoad Step从平面文件中加载玩家信息,而 gameLoad Step对游戏也是如此。最后的Step,playerSummarization,然后根据提供的游戏汇总每个玩家的统计信息。假定“ playerLoad”加载的文件仅必须加载一次,但是“ gameLoad”将加载在特定目录中找到的所有游戏,并在将它们成功加载到数据库后将其删除。结果,playerLoad Step不包含其他配置。它几乎可以无限启动,如果完成,将被跳过。但是,’gameLoad’Step每次都需要运行,以防自上次执行以来删除了多余的文件。为了始终启动,将“ allow-start-if-complete”设置为“ true”。 (假设装入的数据库表游戏具有过程指示器,以确保可以通过汇总步骤正确找到新游戏)。摘要Step是Job中最重要的摘要,其初始限制为 3.这很有用,因为如果步骤连续失败,则会将新的退出代码返回给控制作业执行的操作员,并且在进行人工干预之前,不允许再次启动。

Note

该工作仅出于示例目的,与示例 Item 中找到的 footballJob 不同。

Run 1:

- playerLoad 已执行并成功完成,将 400 位玩家添加到“ PLAYERS”表中。

- 执行 gameLoad 并处理 11 个值得游戏数据的文件,并将其内容加载到“ GAMES”表中。

- playerSummarization 开始处理,并在 5 分钟后失败。

Run 2:

- playerLoad 未运行,因为它已经成功完成,并且 allow-start-if-complete 为’false’(默认值)。

- gameLoad 再次执行并处理另外 2 个文件,并将它们的内容也加载到“ GAMES”表中(带有过程指示器,指示它们尚未处理)

- playerSummarization 开始处理所有剩余的游戏数据(使用过程指示器进行过滤),并在 30 分钟后再次失败。

Run 3:

- playerLoad 未运行,因为它已经成功完成,并且 allow-start-if-complete 为’false’(默认值)。

- gameLoad 再次执行并处理另外 2 个文件,并将它们的内容也加载到“ GAMES”表中(带有过程指示器,指示它们尚未处理)

- playerSummarization 没有开始,并且作业被立即终止,因为这是 playerSummarization 的第三次执行,并且其限制仅为 2.必须提高限制,或者必须将

Job作为新的JobInstance执行。

5.1.5 配置跳过逻辑

在许多情况下,处理时遇到的错误不应导致Step失败,而应跳过这些错误。通常这是必须由了解数据本身及其含义的人做出的决定。例如,财务数据可能无法跳过,因为它会导致资金被转移,这需要完全准确。另一方面,加载供应商列表可能会导致跳过。如果由于格式错误或缺少必要的信息而未加载供应商,则可能不会出现问题。通常,这些不良记录也会被记录下来,稍后在讨论侦听器时将予以覆盖。

<step id="step1">

<tasklet>

<chunk reader="flatFileItemReader" writer="itemWriter"

commit-interval="10" skip-limit="10">

<skippable-exception-classes>

<include class="org.springframework.batch.item.file.FlatFileParseException"/>

</skippable-exception-classes>

</chunk>

</tasklet>

</step>

在此示例中,使用了FlatFileItemReader,并且在任何时候抛出FlatFileParseException都会被跳过并计入总跳过限制 10.在步骤执行过程中,分别对读取,处理和写入的跳过进行计数,该限制适用于所有人。一旦达到跳过限制,找到的下一个异常将导致该步骤失败。

上面的示例的一个问题是除FlatFileParseException之外的任何其他异常都将导致Job失败。在某些情况下,这可能是正确的行为。但是,在其他情况下,可能更容易确定哪些异常应导致失败并跳过其他所有操作:

<step id="step1">

<tasklet>

<chunk reader="flatFileItemReader" writer="itemWriter"

commit-interval="10" skip-limit="10">

<skippable-exception-classes>

<include class="java.lang.Exception"/>

<exclude class="java.io.FileNotFoundException"/>

</skippable-exception-classes>

</chunk>

</tasklet>

</step>

通过“包含” java.lang.Exception作为可跳过的异常类,该配置指示所有Exception都是可跳过的。但是,通过“排除” java.io.FileNotFoundException,配置将可跳过的异常类的列表优化为全部Exception 除 FileNotFoundException。如果遇到任何排除在外的异常类将是致命的(即不被跳过)。

对于遇到的任何异常,可跳过性将由类层次结构中最接近的超类确定。任何未分类的异常将被视为“致命”异常。 <include/>和<exclude/>元素的 Sequences 无关紧要。

5.1.6 配置重试逻辑

在大多数情况下,您希望异常导致跳过或Step失败。但是,并非所有 exception 都是确定性的。如果在读取时遇到FlatFileParseException,则该记录将始终被抛出;重置ItemReader将无济于事。但是,对于其他异常,例如DeadlockLoserDataAccessException,它指示当前进程已尝试更新另一个进程已锁定的记录,await 并重试可能会导致成功。在这种情况下,应配置重试:

<step id="step1">

<tasklet>

<chunk reader="itemReader" writer="itemWriter"

commit-interval="2" retry-limit="3">

<retryable-exception-classes>

<include class="org.springframework.dao.DeadlockLoserDataAccessException"/>

</retryable-exception-classes>

</chunk>

</tasklet>

</step>

Step允许限制单个 Item 的重试次数,以及“可重试”的 exception 列表。有关重试工作方式的更多详细信息,请参见第 9 章,重试。

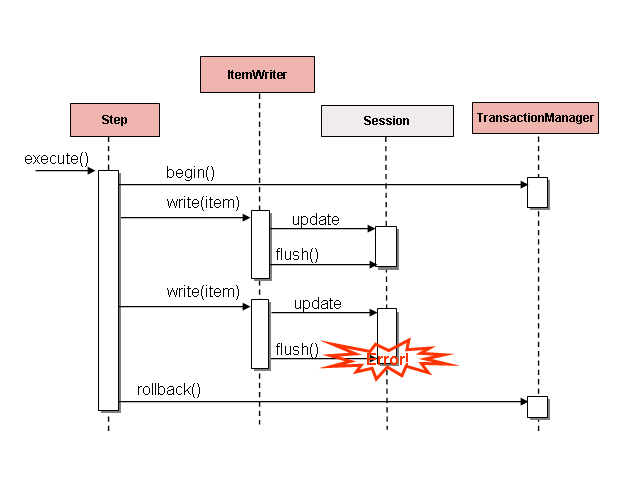

5.1.7 控制回滚

默认情况下,无论重试还是跳过,从ItemWriter引发的任何异常都将导致由Step控制的事务回滚。如果如上所述配置了 skip,则从ItemReader引发的异常不会导致回滚。但是,在许多情况下,从ItemWriter引发的异常不应导致回滚,因为没有采取任何行动来使事务无效。因此,可以为Step配置一系列不应引起回滚的异常。

<step id="step1">

<tasklet>

<chunk reader="itemReader" writer="itemWriter" commit-interval="2"/>

<no-rollback-exception-classes>

<include class="org.springframework.batch.item.validator.ValidationException"/>

</no-rollback-exception-classes>

</tasklet>

</step>

Transactional Readers

ItemReader的基本 Contract 是仅向前。该步骤可缓冲读取器的 Importing,因此在回滚的情况下,无需从读取器中重新读取 Item。但是,在某些情况下,Reader 是构建在诸如 JMS 队列之类的事务资源之上的。在这种情况下,由于队列与回滚的事务相关,因此将从队列中拉出的消息放回去。因此,可以将步骤配置为不缓冲 Item:

<step id="step1">

<tasklet>

<chunk reader="itemReader" writer="itemWriter" commit-interval="2"

is-reader-transactional-queue="true"/>

</tasklet>

</step>

5.1.8 事务属性

事务属性可用于控制隔离,传播和超时设置。可以在 spring 核心文档中找到有关设置事务属性的更多信息。

<step id="step1">

<tasklet>

<chunk reader="itemReader" writer="itemWriter" commit-interval="2"/>

<transaction-attributes isolation="DEFAULT"

propagation="REQUIRED"

timeout="30"/>

</tasklet>

</step>

5.1.9 在步骤中注册 ItemStreams

该步骤必须在其生命周期的必要时点处理ItemStream回调。 (有关ItemStream界面的更多信息,请参考第 6.4 节“ ItemStream”),这对于步骤失败至关重要,并且可能需要重新启动,因为ItemStream接口是该步骤获取有关两次执行之间的持久状态所需信息的地方。

如果ItemReader,ItemProcessor或ItemWriter本身实现ItemStream接口,则将自动注册这些接口。任何其他流都需要单独注册。这通常是存在间接依赖性的情况,例如将委托注入到读取器和写入器中。可以通过’streams’元素在Step上注册流,如下所示:

<step id="step1">

<tasklet>

<chunk reader="itemReader" writer="compositeWriter" commit-interval="2">

<streams>

<stream ref="fileItemWriter1"/>

<stream ref="fileItemWriter2"/>

</streams>

</chunk>

</tasklet>

</step>

<beans:bean id="compositeWriter"

class="org.springframework.batch.item.support.CompositeItemWriter">

<beans:property name="delegates">

<beans:list>

<beans:ref bean="fileItemWriter1" />

<beans:ref bean="fileItemWriter2" />

</beans:list>

</beans:property>

</beans:bean>

在上面的示例中,CompositeItemWriter不是ItemStream,但是它的两个委托都是。因此,必须将两个委托 Writer 都明确注册为流,以便框架正确处理它们。 ItemReader不需要显式注册为流,因为它是Step的直接属性。现在,该步骤将可重新启动,并且如果发生故障,读取器和写入器的状态将正确保留。

5.1.10 拦截步骤执行

就像Job一样,在执行Step期间会发生许多事件,用户可能需要执行某些功能。例如,为了写出需要页脚的平面文件,必须在Step完成时通知ItemWriter,以便页脚可以写入。这可以通过许多Step作用域侦听器之一来完成。

任何实现StepListenerextensions 之一的类(但由于接口本身是空的,因此不能实现该接口本身)可以通过 listeners 元素应用于步骤。 listeners 元素在步骤,tasklet 或块声明中有效。建议您在其功能适用的级别声明监听器,或者如果它具有多种功能(例如StepExecutionListener和ItemReadListener),则在其适用的最细粒度级别声明监听器(在给定的示例中为大块)。

<step id="step1">

<tasklet>

<chunk reader="reader" writer="writer" commit-interval="10"/>

<listeners>

<listener ref="chunkListener"/>

</listeners>

</tasklet>

</step>

如果使用命名空间<step>元素或*StepFactoryBean工厂之一,则本身实现StepListener接口之一的ItemReader,ItemWriter或ItemProcessor将自动向Step注册。这仅适用于直接注入Step的组件:如果侦听器嵌套在另一个组件中,则需要对其进行显式注册(如上所述)。

除了StepListener接口之外,还提供 Comments 来解决相同的问题。普通的旧 Java 对象可以使用带有这些注解的方法,然后将其转换为相应的StepListener类型。Comments 诸如ItemReader或ItemWriter或Tasklet之类的块组件的自定义实现也是很常见的。 XML 解析器针对<listener/>元素对 Comments 进行了分析,因此您所需要做的就是使用 XML 名称空间通过一个步骤注册侦听器。

StepExecutionListener

StepExecutionListener代表Step执行的最通用的侦听器。它允许在Step开始之前和结束之后发出通知,无论它是正常结束还是失败:

public interface StepExecutionListener extends StepListener {

void beforeStep(StepExecution stepExecution);

ExitStatus afterStep(StepExecution stepExecution);

}

ExitStatus是afterStep的返回类型,以使侦听器有机会修改在Step完成时返回的退出代码。

与此接口对应的 Comments 为:

@BeforeStep@AfterStep

ChunkListener

块定义为在事务范围内处理的 Item。在每个提交间隔提交事务都会提交一个“块”。 ChunkListener对于在块开始处理之前或块成功完成之后执行逻辑很有用:

public interface ChunkListener extends StepListener {

void beforeChunk();

void afterChunk();

}

在事务开始之后但在ItemReader上调用read之前,将调用beforeChunk方法。相反,afterChunk在提交块之后被调用(如果发生回滚则根本不调用)。

与此接口对应的 Comments 为:

@BeforeChunk@AfterChunk

当没有块声明时,可以应用ChunkListener:它是TaskletStep负责调用ChunkListener,因此它也适用于非面向 Item 的 Tasklet(在 Tasklet 之前和之后调用)。

ItemReadListener

在上面讨论跳过逻辑时,曾提到记录跳过的记录可能会有所帮助,以便以后进行处理。如果出现读取错误,可以使用ItemReaderListener:完成

public interface ItemReadListener<T> extends StepListener {

void beforeRead();

void afterRead(T item);

void onReadError(Exception ex);

}

每次在ItemReader上调用read之前,将调用beforeRead方法。每次成功调用read之后,将调用afterRead方法,并将传递已读取的 Item。如果读取时出错,则将调用onReadError方法。将提供遇到的异常,以便可以将其记录下来。

与此接口对应的 Comments 为:

@BeforeRead@AfterRead@OnReadError

ItemProcessListener

与ItemReadListener一样,可以将 Item 的处理“侦听”为:

public interface ItemProcessListener<T, S> extends StepListener {

void beforeProcess(T item);

void afterProcess(T item, S result);

void onProcessError(T item, Exception e);

}

beforeProcess方法将在ItemProcessor上的process之前调用,并交给将要处理的 Item。成功处理该 Item 后,将调用afterProcess方法。如果处理时出错,则将调用onProcessError方法。将提供遇到的异常和尝试处理的 Item,以便可以记录它们。

与此接口对应的 Comments 为:

@BeforeProcess@AfterProcess@OnProcessError

ItemWriteListener

可以使用ItemWriteListener来“听”Item 的书写:

public interface ItemWriteListener<S> extends StepListener {

void beforeWrite(List<? extends S> items);

void afterWrite(List<? extends S> items);

void onWriteError(Exception exception, List<? extends S> items);

}

beforeWrite方法将在ItemWriter上的write之前被调用,并且将被写入的内容交给该方法。成功写入 Item 后,将调用afterWrite方法。如果写入时出错,则将调用onWriteError方法。将提供遇到的异常和尝试写入的 Item,以便可以记录它们。

与此接口对应的 Comments 为:

@BeforeWrite@AfterWrite@OnWriteError

SkipListener

ItemReadListener,ItemProcessListener和ItemWriteListener都提供了用于通知错误的机制,但没有一个机制会通知您实际上已跳过了一条记录。例如,即使重试并成功执行onWriteError也会被调用。因此,有一个单独的界面可用于跟踪跳过的 Item:

public interface SkipListener<T,S> extends StepListener {

void onSkipInRead(Throwable t);

void onSkipInProcess(T item, Throwable t);

void onSkipInWrite(S item, Throwable t);

}

每次在阅读过程中跳过某项都会调用onSkipInRead。应当注意,回滚可能导致同一项被注册为多次跳过。写入时跳过某项时,将调用onSkipInWrite。由于已成功读取(而不是跳过)该 Item,因此还提供了该 Item 本身作为参数。

与此接口对应的 Comments 为:

@OnSkipInRead@OnSkipInWrite@OnSkipInProcess

跳过侦听器和事务

SkipListener最常见的用例之一是注销跳过的 Item,以便可以使用另一个批处理甚至人工流程来评估和解决导致跳过的问题。由于在很多情况下原始事务可能会被回滚,因此 Spring Batch 提供了两个保证:

- 适当的跳过方法(取决于错误发生的时间)将仅对每个 Item 调用一次。

SkipListener将始终在事务提交之前被调用。这是为了确保ItemWriter内的故障不会使侦听器调用的任何事务资源回滚。

5.2 TaskletStep

块处理不是在Step中处理的唯一方法。如果Step必须包含一个简单的存储过程调用怎么办?您可以将调用实现为ItemReader,并在过程完成后返回 null,但这有点不自然,因为需要使用无操作ItemWriter。 Spring Batch 为此场景提供了TaskletStep。

Tasklet是一个简单的接口,具有一个方法execute,它将由TaskletStep反复调用,直到它返回RepeatStatus.FINISHED或引发异常以指示失败。对Tasklet的每次调用都包装在一个事务中。 Tasklet实现者可以调用存储过程,脚本或简单的 SQL 更新语句。要创建TaskletStep,\ 元素的’ref’属性应引用一个定义Tasklet对象的 bean。在\ 内不应使用\ 元素:

<step id="step1">

<tasklet ref="myTasklet"/>

</step>

Note

如果TaskletStep实现了此接口,它将自动将 Tasklet 注册为StepListener

5.2.1 TaskletAdapter

与ItemReader和ItemWriter接口的其他适配器一样,Tasklet接口包含一个实现,可以使其自身适应任何现有的类:TaskletAdapter。一个可能有用的示例是现有的 DAO,用于更新一组记录上的标志。 TaskletAdapter可用于调用此类,而不必为Tasklet接口编写适配器:

<bean id="myTasklet" class="o.s.b.core.step.tasklet.MethodInvokingTaskletAdapter">

<property name="targetObject">

<bean class="org.mycompany.FooDao"/>

</property>

<property name="targetMethod" value="updateFoo" />

</bean>

5.2.2 Tasklet 实现示例

许多批处理作业包含必须在主处理开始之前执行的步骤,以设置各种资源,或者在处理完成后清理这些资源。对于需要大量处理文件的工作,通常需要在成功将文件上载到其他位置后在本地删除某些文件。下面的示例摘自 Spring Batch 示例 Item,是一个Tasklet实现,它具有以下职责:

public class FileDeletingTasklet implements Tasklet, InitializingBean {

private Resource directory;

public RepeatStatus execute(StepContribution contribution,

ChunkContext chunkContext) throws Exception {

File dir = directory.getFile();

Assert.state(dir.isDirectory());

File[] files = dir.listFiles();

for (int i = 0; i < files.length; i++) {

boolean deleted = files[i].delete();

if (!deleted) {

throw new UnexpectedJobExecutionException("Could not delete file " +

files[i].getPath());

}

}

return RepeatStatus.FINISHED;

}

public void setDirectoryResource(Resource directory) {

this.directory = directory;

}

public void afterPropertiesSet() throws Exception {

Assert.notNull(directory, "directory must be set");

}

}

上面的Tasklet实现将删除给定目录中的所有文件。应当注意,execute方法将仅被调用一次。剩下的就是从Step引用Tasklet:

<job id="taskletJob">

<step id="deleteFilesInDir">

<tasklet ref="fileDeletingTasklet"/>

</step>

</job>

<beans:bean id="fileDeletingTasklet"

class="org.springframework.batch.sample.tasklet.FileDeletingTasklet">

<beans:property name="directoryResource">

<beans:bean id="directory"

class="org.springframework.core.io.FileSystemResource">

<beans:constructor-arg value="target/test-outputs/test-dir" />

</beans:bean>

</beans:property>

</beans:bean>

5.3 控制步骤流程

由于能够将一个拥有的工作中的各个步骤组合在一起,因此需要能够控制工作如何从一个步骤“流向”另一个步骤。 Step的失败并不一定意味着Job应该会失败。此外,可能有不止一种类型的“成功”确定接下来应执行哪个Step。根据一组步骤的配置方式,某些步骤甚至可能根本无法处理。

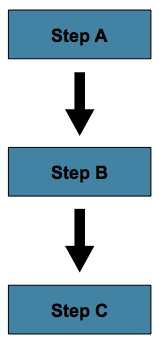

5.3.1Sequences 流

最简单的流程场景是一项工作,其中所有步骤都按 Sequences 执行:

这可以使用 step 元素的’next’属性来实现:

<job id="job">

<step id="stepA" parent="s1" next="stepB" />

<step id="stepB" parent="s2" next="stepC"/>

<step id="stepC" parent="s3" />

</job>

在上述情况下,“步骤 A”将首先执行,因为它是列出的第一个Step。如果“步骤 A”正常完成,则将执行“步骤 B”,依此类推。但是,如果“步骤 A”失败,则整个Job将失败,并且“步骤 B”将不会执行。

Note

使用 Spring Batch 名称空间时,配置中列出的第一步将*总是*成为Job执行的第一步。其他步骤元素的 Sequences 无关紧要,但是第一步必须始终首先出现在 xml 中。

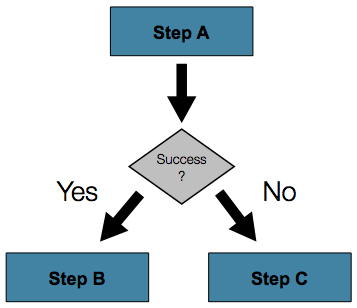

5.3.2 条件流

在上面的示例中,只有两种可能性:

Step成功,应执行下一个Step。Step失败,因此Job应该失败。

在许多情况下,这可能就足够了。但是,如果Step的故障应触发一个不同的Step而不是引起故障的情况呢?

为了处理更复杂的场景,Spring Batch 名称空间允许在 step 元素内定义转换元素。一种这样的过渡是“下一个”元素。与“ next”属性类似,“ next”元素将告诉Job接下来执行哪个Step。但是,与该属性不同,给定Step允许任何数量的“ next”元素,并且在失败的情况下没有默认行为。这意味着,如果使用过渡元素,则必须明确定义Step过渡的所有行为。还要注意,单个步骤不能同时具有“下一个”属性和过渡元素。

next 元素指定要匹配的模式以及下一步要执行的步骤:

<job id="job">

<step id="stepA" parent="s1">

<next on="*" to="stepB" />

<next on="FAILED" to="stepC" />

</step>

<step id="stepB" parent="s2" next="stepC" />

<step id="stepC" parent="s3" />

</job>

过渡元素的“ on”属性使用简单的模式匹配方案来匹配Step的执行所产生的ExitStatus。模式中仅允许使用两个特殊字符:

- “ *”将零个或多个字符

- “?”将完全匹配一个字符

例如,“ c * t”将匹配“ cat”和“ count”,而“ c?t”将匹配“ cat”但不匹配“ count”。

尽管Step上的过渡元素数量没有限制,但是如果Step的执行导致ExitStatus未被元素覆盖,则框架将引发异常,并且Job将会失败。该框架将自动排序从最具体到最不具体的过渡。这意味着即使在上面的示例中将元素替换为“ stepA”,“ _ FAILED”的ExitStatus仍将进入“ stepC”。

批次状态与退出状态

为条件流配置Job时,了解BatchStatus和ExitStatus之间的区别很重要。 BatchStatus是同时为JobExecution和StepExecution的属性的枚举,框架使用它来记录Job或Step的状态。它可以是以下值之一:COMPLETED,STARTING,STARTED,STOPPING,STOPPED,FAILED,ABANDONED 或 UNKNOWN。其中大多数是不言自明的:COMPLETED 是在步骤或作业成功完成时设置的状态,在失败时设置 FAILED,等等。上面的示例包含以下“ next”元素:

<next on="FAILED" to="stepB" />

乍一 Watch,似乎“ on”属性引用了它所属的Step的BatchStatus。但是,它实际上引用了Step的ExitStatus。顾名思义,ExitStatus代表Step完成执行后的状态。更具体地说,上面的“ next”元素引用ExitStatus的退出代码。要用英语编写,它说:“如果退出代码失败,则转到步骤 B”。默认情况下,退出代码始终与该步骤的BatchStatus相同,这就是上面的 Importing 起作用的原因。但是,如果退出代码需要不同怎么办?一个很好的例子来自 samplesItem 中的 skip sample 作业:

<step id="step1" parent="s1">

<end on="FAILED" />

<next on="COMPLETED WITH SKIPS" to="errorPrint1" />

<next on="*" to="step2" />

</step>

上面的步骤有三种可能性:

Step失败,在这种情况下作业应该失败。Step成功完成。Step已成功完成,但退出代码为“ COMPLETED WITH SKIPS”。在这种情况下,应运行不同的步骤来处理错误。

以上配置将起作用。但是,需要根据跳过记录的执行条件来更改退出代码:

public class SkipCheckingListener extends StepExecutionListenerSupport {

public ExitStatus afterStep(StepExecution stepExecution) {

String exitCode = stepExecution.getExitStatus().getExitCode();

if (!exitCode.equals(ExitStatus.FAILED.getExitCode()) &&

stepExecution.getSkipCount() > 0) {

return new ExitStatus("COMPLETED WITH SKIPS");

}

else {

return null;

}

}

}

上面的代码是StepExecutionListener,首先检查以确保Step成功,然后检查StepExecution上的跳过计数是否大于 0.如果同时满足这两个条件,则新的ExitStatus的退出代码为“ COMPLETED WITH SKIPS”返回。

5.3.3 配置停止

在讨论BatchStatus 和 ExitStatus之后,您可能会想知道如何为Job确定BatchStatus和ExitStatus。通过已执行的代码确定Step的这些状态时,将基于配置确定Job的状态。

到目前为止,讨论的所有作业配置都至少具有一个没有过渡的最终Step。例如,执行以下步骤后,Job将结束:

<step id="stepC" parent="s3"/>

如果未为Step定义过渡,则Job的状态将定义如下:

- 如果

Step以ExitStatusFAILED 结尾,则Job的BatchStatus和ExitStatus都将变为 FAILED。 - 否则,

Job的BatchStatus和ExitStatus都将被完成。

尽管这种终止批处理作业的方法对于某些批处理作业(例如简单的 Sequences 步骤作业)已足够,但是可能需要自定义定义的作业停止方案。为此,Spring Batch 提供了三个过渡元素来停止Job(除了我们之前讨论的“next” element之外)。这些停止元素中的每一个都将停止具有特定BatchStatus的Job。重要的是要注意,停止过渡元素将不会对Job中任何Step的BatchStatus或ExitStatus产生影响:这些元素只会影响Job的最终状态。例如,作业中的每个步骤都可能具有“已失败”状态,但是作业具有“已完成”状态,反之亦然。

“结束”元素

‘end’元素指示Job以BatchStatus的 COMPLETED 停止。状态为 COMPLETED 的Job无法重新启动(框架将抛出JobInstanceAlreadyCompleteException)。 ‘end’元素还允许使用可选的’exit-code’属性,该属性可用于自定义Job的ExitStatus。如果未提供’exit-code’属性,则默认情况下ExitStatus将为“ COMPLETED”,以匹配BatchStatus。

在以下情况下,如果步骤 2 失败,则Job将以BatchStatus的 COMPLETED 停止,而ExitStatus的“ COMPLETED”停止,并且 step3 将不执行;否则,执行将移至步骤 3.请注意,如果步骤 2 失败,则Job将无法重新启动(因为状态为 COMPLETED)。

<step id="step1" parent="s1" next="step2">

<step id="step2" parent="s2">

<end on="FAILED"/>

<next on="*" to="step3"/>

</step>

<step id="step3" parent="s3">

“失败”元素

“失败”元素指示Job以BatchStatus的 FAILED 停止。与’end’元素不同,’fail’元素不会阻止Job重新启动。 ‘fail’元素还允许使用可选的’exit-code’属性,该属性可用于自定义Job的ExitStatus。如果未提供’exit-code’属性,则默认情况下ExitStatus为“ FAILED”,以匹配BatchStatus。

在以下情况下,如果步骤 2 失败,则Job将以BatchStatus失败而停止,而ExitStatus则为“早期终止”而停止,步骤 3 将不执行;否则,执行将移至步骤 3.此外,如果步骤 2 失败,并且Job重新启动,则将在步骤 2 再次开始执行。

<step id="step1" parent="s1" next="step2">

<step id="step2" parent="s2">

<fail on="FAILED" exit-code="EARLY TERMINATION"/>

<next on="*" to="step3"/>

</step>

<step id="step3" parent="s3">

“停止”元素

‘stop’元素指示Job以BatchStatus的 STOPPED 停止。停止Job可以暂时中断处理,以便操作员可以在重新启动Job之前采取一些措施。 ‘stop’元素需要一个’restart’属性,该属性指定Job is restarted时应该执行的步骤。

在以下情况下,如果 step1 以 COMPLETE 完成,则作业将停止。重新启动后,将在步骤 2 开始执行。

<step id="step1" parent="s1">

<stop on="COMPLETED" restart="step2"/>

</step>

<step id="step2" parent="s2"/>

5.3.4 程序流程决策

在某些情况下,可能需要比ExitStatus更多的信息来决定下一步执行哪个步骤。在这种情况下,可以使用JobExecutionDecider来辅助决策。

public class MyDecider implements JobExecutionDecider {

public FlowExecutionStatus decide(JobExecution jobExecution, StepExecution stepExecution) {

if (someCondition) {

return "FAILED";

}

else {

return "COMPLETED";

}

}

}

在作业配置中,“决策”标签将指定要使用的决策器以及所有转换。

<job id="job">

<step id="step1" parent="s1" next="decision" />

<decision id="decision" decider="decider">

<next on="FAILED" to="step2" />

<next on="COMPLETED" to="step3" />

</decision>

<step id="step2" parent="s2" next="step3"/>

<step id="step3" parent="s3" />

</job>

<beans:bean id="decider" class="com.MyDecider"/>

5.3.5 分流

到目前为止,所描述的每种情况都涉及一个Job,它以线性方式一次执行其Step。除了这种典型的样式外,Spring Batch 命名空间还允许使用“ split”元素使用并行流来配置作业。如下所示,“ split”元素包含一个或多个“ flow”元素,可以在其中定义整个单独的流。 “拆分”元素还可以包含任何先前讨论的过渡元素,例如“下一个”属性或“下一个”,“结束”,“失败”或“暂停”元素。

<split id="split1" next="step4">

<flow>

<step id="step1" parent="s1" next="step2"/>

<step id="step2" parent="s2"/>

</flow>

<flow>

<step id="step3" parent="s3"/>

</flow>

</split>

<step id="step4" parent="s4"/>

5.3.6 外部化作业之间的流程定义和依赖性

可以将作业中的部分流程外部化为单独的 Bean 定义,然后重新使用。有两种方法可以做到这一点,第一种是简单地将流声明为对其他地方定义的引用:

<job id="job">

<flow id="job1.flow1" parent="flow1" next="step3"/>

<step id="step3" parent="s3"/>

</job>

<flow id="flow1">

<step id="step1" parent="s1" next="step2"/>

<step id="step2" parent="s2"/>

</flow>

像这样定义外部流程的作用仅仅是将外部流程中的步骤插入作业中,就好像它们已被内联声明一样。这样,许多作业可以引用相同的模板流,并将这些模板组成不同的逻辑流。这也是分离单个流的集成测试的好方法。

外部化流程的另一种形式是使用JobStep。 JobStep与FlowStep类似,但是实际上为指定流程中的步骤创建并启动了单独的作业执行。这是一个例子:

<job id="jobStepJob" restartable="true">

<step id="jobStepJob.step1">

<job ref="job" job-launcher="jobLauncher"

job-parameters-extractor="jobParametersExtractor"/>

</step>

</job>

<job id="job" restartable="true">...</job>

<bean id="jobParametersExtractor" class="org.spr...DefaultJobParametersExtractor">

<property name="keys" value="input.file"/>

</bean>

作业参数提取器是一种策略,用于确定Step的ExecutionContext如何转换为要执行的 Job 的JobParameters。 JobStep在您希望有一些更精细的选项来监视和报告作业和步骤时很有用。使用JobStep通常也可以很好地回答以下问题:“如何在作业之间创建依赖关系?”。这是将大型系统分解为较小的模块并控制作业流程的好方法。

5.4 作业和步骤属性的后期绑定

上面的 XML 和 Flat File 示例都使用 Spring Resource抽象来获取文件。之所以有效,是因为Resource有一个 getFile 方法,该方法返回java.io.File。可以使用标准 Spring 构造来配置 XML 和平面文件资源:

<bean id="flatFileItemReader"

class="org.springframework.batch.item.file.FlatFileItemReader">

<property name="resource"

value="file://outputs/20070122.testStream.CustomerReportStep.TEMP.txt" />

</bean>

上面的Resource将从指定的文件系统位置加载文件。请注意,绝对位置必须以双斜杠(“ //”)开头。在大多数 spring 应用程序中,此解决方案足够好,因为它们的名称在编译时就已知。但是,在批处理方案中,可能需要在运行时将文件名确定为作业的参数。可以使用-D 参数(即系统属性)解决此问题:

<bean id="flatFileItemReader"

class="org.springframework.batch.item.file.FlatFileItemReader">

<property name="resource" value="${input.file.name}" />

</bean>

要使该解决方案起作用,所需要做的只是一个系统参数(-Dinput.file.name =“ file://file.txt”)。 (请注意,尽管此处可以使用PropertyPlaceholderConfigurer,但始终设置系统属性不是必需的,因为 Spring 中的ResourceEditor已经过滤并在系统属性上进行了占位符替换.)

通常,在批处理设置中,最好在作业的JobParameters中参数化文件名,而不是通过系统属性来访问文件名。为此,Spring Batch 允许后期绑定各种 Job 和 Step 属性:

<bean id="flatFileItemReader" scope="step"

class="org.springframework.batch.item.file.FlatFileItemReader">

<property name="resource" value="#{jobParameters['input.file.name']}" />

</bean>

可以通过相同的方式访问JobExecution和StepExecution级别ExecutionContext:

<bean id="flatFileItemReader" scope="step"

class="org.springframework.batch.item.file.FlatFileItemReader">

<property name="resource" value="#{jobExecutionContext['input.file.name']}" />

</bean>

<bean id="flatFileItemReader" scope="step"

class="org.springframework.batch.item.file.FlatFileItemReader">

<property name="resource" value="#{stepExecutionContext['input.file.name']}" />

</bean>

Note

任何使用后期绑定的 bean 必须使用 scope =“ step”声明。请参阅第 5.4.1 节“步骤范围”更多信息。

Note

如果您使用的是 Spring 3.0(或更高版本),则步进作用域 Bean 中的表达式将使用 Spring Expression Language,这是一种功能强大的通用语言,具有许多有趣的功能。为了提供向后兼容性,如果 Spring Batch 检测到存在较旧版本的 Spring,它将使用功能较弱且解析规则稍有不同的本机表达式语言。主要区别在于,上面示例中的 map 键不需要在 Spring 2.5 中用引号引起来,但是在 Spring 3.0 中引号是必需的。

5.4.1 步骤范围

上面所有的后期绑定示例都在 bean 定义中声明了“ step”的范围:

<bean id="flatFileItemReader" scope="step"

class="org.springframework.batch.item.file.FlatFileItemReader">

<property name="resource" value="#{jobParameters[input.file.name]}" />

</bean>

为了使用后期绑定,需要使用Step范围,因为在Step启动之前实际上无法实例化 bean,这样才能找到属性。因为默认情况下它不是 Spring 容器的一部分,所以必须使用batch命名空间来显式添加范围:

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:batch="http://www.springframework.org/schema/batch"